Datacenter: Hohes Einsparpotenzial durch 3D bei DRAM und Flash

SSDs sind im Datacenter längst nichts mehr Neues, wohl aber, mit welcher Macht sie mittlerweile Einzug in Unternehmen und Rechenzentren halten. Mit der neuen 3D-Architektur verbessern sowohl DRAMs als auch Flash-Speicher nicht nur die Performance in Servern und Storage-Systemen, sondern bieten auch ein hohes Einsparpotenzial.

Wir sprachen mit Thomas Arenz, Director Marcom + Strategic Business Development bei Samsung Semiconductor Europe, über die Entwicklung in den Bereichen TSV-3D-DRAM und 3D-V-NAND-basierter SSDs.

Wo sieht sich Samsung als DRAM- und SSD-Hersteller im Datacenter?

Thomas Arenz, SamsungArenz: Datacenter haben es in diesen Tagen nicht leicht. Der verfügbare Platz für Server im Rechenzentrum (RZ) ist endlich, der zulässige Stromverbrauch gedeckelt, während die Nachfrage nach den täglich verarbeitbaren Datenmengen rasant ansteigt. Ziel ist es hier, die Balance zu halten zwischen dem Bedarf nach mehr Kapazität, der gesteigerten Nachfrage nach Performance, und gleichzeitig müssen hier natürlich auch die Preise passen.

Thomas Arenz, SamsungArenz: Datacenter haben es in diesen Tagen nicht leicht. Der verfügbare Platz für Server im Rechenzentrum (RZ) ist endlich, der zulässige Stromverbrauch gedeckelt, während die Nachfrage nach den täglich verarbeitbaren Datenmengen rasant ansteigt. Ziel ist es hier, die Balance zu halten zwischen dem Bedarf nach mehr Kapazität, der gesteigerten Nachfrage nach Performance, und gleichzeitig müssen hier natürlich auch die Preise passen.

SSD/DRAM: Herausforderung Rechenzentrum

Wo liegen die Herausforderungen, um den Anforderungen von Rechenzentren gerecht zu werden?

Arenz: Big Data treibt vieles voran, und dies wirkt sich direkt auf den Arbeitsspeicher aus. Überall werden enorme Datenmengen erzeugt, auch privat, zum Beispiel auf Veranstaltungen. Heute wird alles fotografiert und gefilmt. Vom eigenen Smartphone wandern die Aufnahmen dann auf die bekannten Plattformen und verbreiten sich von dort weiter.

Big Data bedeutet ja nicht nur Financial-Risk-Modeling in der Bank, sondern eben auch ganz normale Dinge, die wir jeden Tag benutzen. Dies sind Dienste und Geschäftsmodelle, die durch diese Datenmengen und den kurzen Zugriff auf die Daten ermöglicht werden, egal ob Facebook, Instagram, Amazon oder Uber. Die Liste ist endlos, und kommende IoT-Anwendungen (Internet of Things) werden diesen Bedarf noch einmal vervielfachen. Dadurch ergibt sich eine drastische Nachfrage nach hoch performanter Speicherkapazität. Marktforscher erwarten in den kommenden drei Jahren nahezu eine Verdopplung, vor allem in den Bereichen Mobile und SSDs. Bei NAND attestiert beispielsweise iSuppli dem Markt ein jährliches Wachstum von 42 Prozent.

Das Memory/Storage-Subsystem bewegt sich von einer »ferner liefen« Position an die Pole-Position im Datacenter, auch wenn das noch nicht jedem IT-Manager heute schon so bewusst ist. Und wo wir gerade bei der Formel 1 sind: Ohne Big Data und Echtzeit-Computing wäre diese heute gar nicht mehr möglich, denn die Piloten steuern mit Sensorik vollgestopfte Rennautos, die während des Rennens permanent mit Höchstleistungscomputern im Rennstall kommunizieren, um Rennablauf und Taktik zu optimieren. Ganz zu schweigen von der Designphase dieser Autos, die heute von CFD (Computational Fluid Dynamics) und virtuellen Windkanälen dominiert wird.

Welche Auswirkungen hat dies auf Storage-Systeme und speziell auf Plattenspeicher?

Arenz: Die Festplatte ist deswegen noch lange nicht tot. Selbst wenn alle Speicherhersteller die Produktionskapazitäten für NAND-Flash zusammenlegten, würde dies nicht ausreichen, um die gesamte Nachfrage abzudecken. Was wir jedoch sehen ist, dass Storage mit Tier 0 und Tier 1 in Richtung Flash geht und sogar bereits Tier 2 in der Diskussion ist. Dieser Trend ist sehr deutlich. Wir sehen dies auch in den Absatzzahlen. 2015 konnten wir dreimal so viele SSDs verkaufen wie im Jahr davor. Und nach dem ersten Quartal ist schon abzusehen, dass sich dieser Trend fortsetzt.

Einfluss des Flash- oder DRAM-Typ auf den Server

Macht es in Servern wirklich einen Unterschied, welcher Typ Flash oder DRAM eingesetzt wird?

Arenz: Ja, denn letztlich geht es um immer leistungsfähigere Chips. Und da vor allem um vier wichtige Hauptpunkte: Die Erhöhung der Speicherdichte um mehr Kapazität aus der gleichen Fläche herauszubekommen – natürlich im Verbund mit einer schnelleren Geschwindigkeit, bei gleichzeitiger Reduzierung des Stromverbrauchs und einer möglichst langen Haltbarkeit und Zuverlässigkeit.

Und wie macht sich das jetzt beim DRAM Arbeitsspeicher bemerkbar?

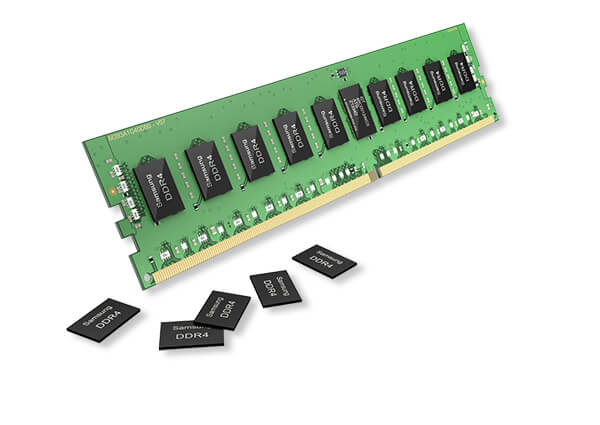

Mit der TSV-3D-Technik passen bis zu 128 Gbyte auf ein DRAM-Modul mit einer Leistung von bis zu 2,4 Gbit/s (Bild: Samsung)..Arenz: Auch wenn man es nicht glaubt, mit modernen Speicherriegeln lässt sich einiges sparen. Nehmen wir beispielsweise ein Server-Szenario mit 96 GByte DDR4-RAM (8 GByte, 20nm, 1,2 V), dass in der Praxis eher am unteren Ende anzusiedeln wäre. In einem kleinen bis mittelgroßen Rechenzentrum werden gut und gerne 1.000 Stück davon betrieben. Mit moderner Prozesstechnologie im 20-Nanometer-Bereich und hoher Speicherdichte reduziert sich der Stromhunger in den Gesamtbetriebskosten um 150.000 bis 200.000 kW. Für Unternehmen zahlt es sich daher schon aus, in die neueste Technologie zu investieren, auch um das Einsparpotenzial der Virtualisierung wirklich voll auszuschöpfen.

Mit der TSV-3D-Technik passen bis zu 128 Gbyte auf ein DRAM-Modul mit einer Leistung von bis zu 2,4 Gbit/s (Bild: Samsung)..Arenz: Auch wenn man es nicht glaubt, mit modernen Speicherriegeln lässt sich einiges sparen. Nehmen wir beispielsweise ein Server-Szenario mit 96 GByte DDR4-RAM (8 GByte, 20nm, 1,2 V), dass in der Praxis eher am unteren Ende anzusiedeln wäre. In einem kleinen bis mittelgroßen Rechenzentrum werden gut und gerne 1.000 Stück davon betrieben. Mit moderner Prozesstechnologie im 20-Nanometer-Bereich und hoher Speicherdichte reduziert sich der Stromhunger in den Gesamtbetriebskosten um 150.000 bis 200.000 kW. Für Unternehmen zahlt es sich daher schon aus, in die neueste Technologie zu investieren, auch um das Einsparpotenzial der Virtualisierung wirklich voll auszuschöpfen.

TSV-DRAMs: schneller und mit höherer Kapazität

Was ist das Besondere an der TSV-Technik?

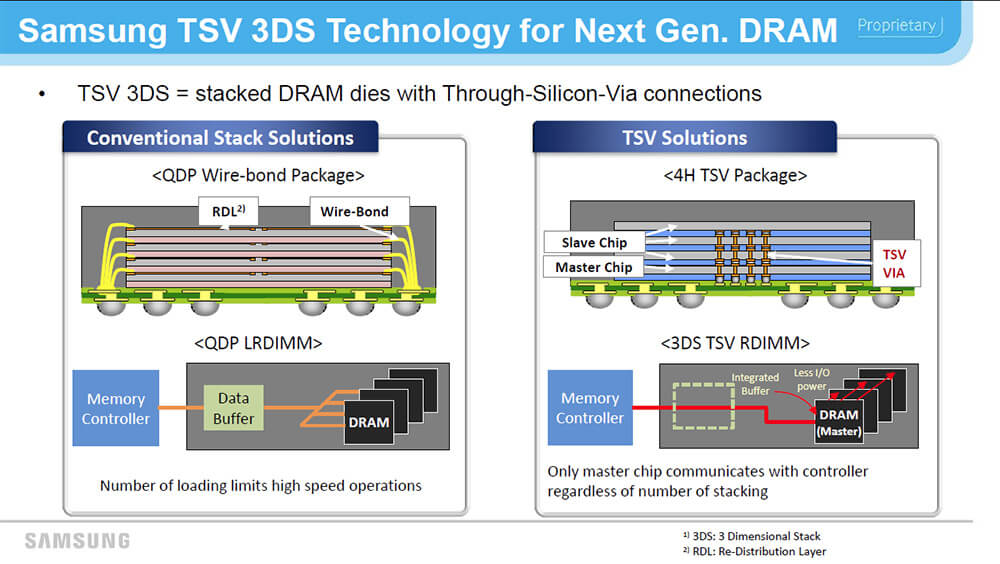

Herkömmlicher DRAM-Aufbau im Vergleich mit der 3D-TSV-Architektur (Grafik: Samsung).Arenz: Es wird natürlich erwartet, dass die Speicherdichte im Server deutlich zunimmt. Wir sehen hier gerade den Übergang von Haswell zu Broadwell als Möglichkeit, den Server-Speicher deutlich auszubauen. Dies ist wiederum Voraussetzung für das zunehmend wichtigere In-Memory-Computing, wie SAP HANA. Vor zwei, drei Jahren haben wir mit Kunden noch über Proof-of-Concepts (PoC) oder Proof-of-Technology (PoT) mit ein bis zwei TByte DRAM pro Server diskutiert. Mittlerweile sind wir bei 12 bis 17 TByte pro Server angelangt. Diese Kapazitätserhöhung hat vor allem auf dem Speicherriegel stattgefunden, denn die Slots auf den Mainboards haben sich nicht exponentiell vervielfacht.

Herkömmlicher DRAM-Aufbau im Vergleich mit der 3D-TSV-Architektur (Grafik: Samsung).Arenz: Es wird natürlich erwartet, dass die Speicherdichte im Server deutlich zunimmt. Wir sehen hier gerade den Übergang von Haswell zu Broadwell als Möglichkeit, den Server-Speicher deutlich auszubauen. Dies ist wiederum Voraussetzung für das zunehmend wichtigere In-Memory-Computing, wie SAP HANA. Vor zwei, drei Jahren haben wir mit Kunden noch über Proof-of-Concepts (PoC) oder Proof-of-Technology (PoT) mit ein bis zwei TByte DRAM pro Server diskutiert. Mittlerweile sind wir bei 12 bis 17 TByte pro Server angelangt. Diese Kapazitätserhöhung hat vor allem auf dem Speicherriegel stattgefunden, denn die Slots auf den Mainboards haben sich nicht exponentiell vervielfacht.

Da sich die Kapazität der Basiskomponenten nicht ohne weiteres vervielfachen lässt, wird bei DRAM mittlerweile gerne gestapelt. Das heißt, mehrere Chips werden innerhalb eines Packages übereinander platziert und dann miteinander verbunden.

Mit TSV-3D-Technologie (Through Silicon Via) erreichen wir mittlerweile Speicher mit 128 GByte auf einem einzigen DRAM-Modul. Gleichzeitig umgehen wir die Limitierungen der konventionellen Wirebonding-Architektur. Bisher wurden gestapelte Chips mit Drähten (wires) und zusätzlichen Controllern miteinander verbunden. Dies steigerte gleichzeitig Komplexität und Stromverbrauch. Allerdings sind die adressierbare Bandbreite und damit die Geschwindigkeit mittlerweile limitiert, denn die vielen Controller lassen sich nicht mehr schneller ansprechen.

TSV-DRAMs hingegen sind über mehrere Tausend TSVs in einem Package miteinander verbunden – wie Fahrstühle in einem Hochhaus – und erreichen derzeit eine Leistung von 2.400 Mbit/s, die in den nächsten Generationen noch weiter gesteigert werden kann. Damit entfällt das Wire-Bonding, und es kommuniziert nicht mehr jeder DRAM Chip mit dem Memory-Controller, sondern nur noch ein einziger Master-Chip. Dies hat insgesamt auch den Effekt, dass sich der Energieverbrauch noch einmal um fast 25 Prozent reduziert.

Bei der nächsten Generation im 10-Nanometer-Prozess werden wir 3.400 Mbit/s erreichen. Die ersten Produkte sollten wir in zwei Jahren sehen.

Storage/Server: Bessere SSDs mit 3D-Architektur

Wie schon angesprochen, kommen in Storage-Systemen zunehmend SSDs zum Einsatz. Auch hier setzt sich eine 3D-Architektur durch. Was zeichnet diese V-NAND-Technologie aus und wie unterscheidet sie sich von herkömmlichen Flash-Speichern?

Arenz: Mit den bisher in Flash und SSDs eingesetzten Planar-NANDs lässt sich kaum noch eine höhere Datendichte erreichen. Dazu rücken die horizontal angeordneten Speicherzellen immer näher zusammen. Und damit steigt die Gefahr, dass sich die Zellen gegenseitig beeinflussen und Daten verändert oder verloren gehen könnten.

Wir setzen daher auf die 3D-V-NAND-Technologie. Gegenüber planaren, zweidimensionalen NANDs sind die Speicherzellen übereinander angeordnet und vertikal miteinander verbunden. Die bisher aus einem leitenden Material bestehende Datenschicht wird in V-NANDs durch einen Isolator ersetzt. Durch die vertikale Anordnung der Zellen ergibt sich eine physisch breitere Bitleitung, die direkt dazu beiträgt, Interferenzen zwischen den Zellen zu unterbinden.

Die Erhöhung der Datendichte von zwei auf drei Bit schafft die Möglichkeit, mehr Speicherkapazität auf einem Chip unterzubringen. Im Datacenter arbeiten wir hier aktuell mit gängigen Kapazitäten von bis zu vier TByte und im Client-Bereich bieten wir bezahlbare SSD mit bis zu zwei TByte an. Zu betonen ist auch, dass trotz der verbesserten Leistung und zusätzlicher Features, wie der Stromersparnis, die SSDs nicht mehr kosten.

Fünfmal schneller mit NVMe

Welche Rolle spielt dabei NVMe und für welche Einsatzszenarien empfehlen sich Enterprise-SSDs?

NVMe verarbeitet mehrere Befehle gleichzeitig und erreicht damit vier- bis fünfmal höhere Performance-Werte als SATA-SSDs (Bild: Samsung).Arenz: NVMe ist letztendlich die Schnittstelle, auf die wir alle gewartet haben. Damit können SSDs ihre Leistungsfähigkeit viel besser ausspielen. Nach dem Motto: Was nutzt der tollste Sportwagen, wenn er von einem Esel gezogen wird? Mit NVMe kann man den Esel abspannen und den Boliden richtig fahren lassen.

NVMe verarbeitet mehrere Befehle gleichzeitig und erreicht damit vier- bis fünfmal höhere Performance-Werte als SATA-SSDs (Bild: Samsung).Arenz: NVMe ist letztendlich die Schnittstelle, auf die wir alle gewartet haben. Damit können SSDs ihre Leistungsfähigkeit viel besser ausspielen. Nach dem Motto: Was nutzt der tollste Sportwagen, wenn er von einem Esel gezogen wird? Mit NVMe kann man den Esel abspannen und den Boliden richtig fahren lassen.

Gegenüber AHCI, wie es SATA bisher verwendet, verarbeitet NVMe mehrere Befehle gleichzeitig und erreicht damit vier- bis fünfmal höhere Performance-Werte als SATA-SSDs. In der Praxis ergeben sich Übertragungsgeschwindigkeiten von 1,5 GByte/s beim Schreiben sequenzieller Daten bzw. 2,5 GByte/s beim Lesen. Workloads lassen sich mit bis zu 300.000 IOPS verarbeiten. Mit herkömmlichen SATA-III-SSDs sind dagegen nur Datenraten von maximal 600 MByte/s und 100.000 IOPS möglich. Unser Flaggschiff, die PM1725, bietet bis zu 6,4 TByte Kapazität, eine Bandbreite von drei GByte/s und eine Million IOPS – damit lässt sich serverseitig schon eine Menge Workload abpuffern, bevor überhaupt Daten mit dem Storage-Netzwerk ausgetauscht werden müssen.

Im Prinzip profitieren alle Anwendungen von den Geschwindigkeitsvorteilen. Zunächst wurden SSDs als Boot-Drive anstelle von HDDs und später als Cache zwischen Server und Storage eingesetzt. Mittlerweile interagieren Server mit kompletten All-Flash-Arrays sowie mit Tiered-Storage-Systemen mit integrierten SSDs.

Unterschied zwischen Enterprise- und Consumer-SSDs

Worin unterscheiden sich Server-SSDs von Consumer-Laufwerken?

Samsungs »PM1633a« mit TLC-NAND bieten bis zu 15,36 TByte Kapazität, eine Datenrate von max. 1,2 GByte/s und 200.000 IOPS.Arenz: Unterschiedliche Workloads benötigen dafür ausgelegte SSDs. Auf der OEM-Seite sind dies bei uns Modelle für Clients, Einzelplatzlösungen und Laptops die vom einfachen Festplattenersatz bis hin zu Performance-Workstation-Lösungen reichen. Bei Server-SSDs hängt das Anforderungsprofil vor allem von der Schreibintensität der Applikation ab. Der Mainstream benötigt im überwiegenden Maße Laufwerke für leseintensive Anwendungen. Das heißt, 90 Prozent lesen und zehn Prozent schreiben. In der Praxis sind dies unter anderem File- und Webserver, Video-in-Demand-Lösungen oder Content-Distribution-Netzwerke. Auf der anderen Seite steht das Thema Mixed-Workload wie zum Beispiel für Datenbank- und Applikations-Server sowie im Cloud-Service-Umfeld bis hin zu Storage-Systemen.

Samsungs »PM1633a« mit TLC-NAND bieten bis zu 15,36 TByte Kapazität, eine Datenrate von max. 1,2 GByte/s und 200.000 IOPS.Arenz: Unterschiedliche Workloads benötigen dafür ausgelegte SSDs. Auf der OEM-Seite sind dies bei uns Modelle für Clients, Einzelplatzlösungen und Laptops die vom einfachen Festplattenersatz bis hin zu Performance-Workstation-Lösungen reichen. Bei Server-SSDs hängt das Anforderungsprofil vor allem von der Schreibintensität der Applikation ab. Der Mainstream benötigt im überwiegenden Maße Laufwerke für leseintensive Anwendungen. Das heißt, 90 Prozent lesen und zehn Prozent schreiben. In der Praxis sind dies unter anderem File- und Webserver, Video-in-Demand-Lösungen oder Content-Distribution-Netzwerke. Auf der anderen Seite steht das Thema Mixed-Workload wie zum Beispiel für Datenbank- und Applikations-Server sowie im Cloud-Service-Umfeld bis hin zu Storage-Systemen.

In beiden Fällen bieten wir SSDs für die drei Schnittstellen, die uns derzeit im Markt begegnen: SATA, SAS und in zunehmenden Maße PCIe mit Unterstützung des NVMe Protokolls. Diese unterscheiden sich auch in Writes-per-Day, Kapazität und Total-Bytes-Written, im Sinne von Lebensdauer.

Vor allem bei der Lebensdauer sollten IT-Manager ihre Anforderungen kennen, denn es ist wie mit einer Prepaid-Karte. Wenn ich normalerweise für 50 Euro im Monat telefoniere, sollte ich mir eine für 60 Euro kaufen, dann hat man noch etwas Reserve und nicht eine für 20 Euro, um sich nach zehn Tagen zu wundern, dass die Karte leer ist. Man muss aber sagen, dieses Verständnis hat sich mittlerweile weitgehend durchgesetzt, wie auch, dass man eine für Server ausgelegte SSD verwenden sollte. Diese kommen mit einer Firmware, die in der Lage ist, mit RAIDs in verschiedenen Varianten zu sprechen. Eine Consumer-SSD kann dies nicht. Ist diese beispielsweise mit der Carbage-Collection beschäftigt und meldet sich nicht beim Controller, denkt dieser, das Laufwerk sei defekt.

Wichtig ist auch das Thema Sustained-Write-Performance. Am Anfang der Lebenszeit erhält man hohe Bandbreiten und IOPS. Mit zunehmendem Füllgrad kann es sein, dass die Schreibgeschwindigkeit von vorher 90k auf ein 1k abfällt. Unsere Enterprise-SSDs bieten eine Sustained-Performance von mindestens 15k Write-IOPS. Unsere Firmware erlaubt zudem das Over-Provisioning (Standard 7 %) anzupassen. Wer nicht die volle Kapazität benötigt und anstelle von 480 auch mit 360 GByte auskommt, verdoppelt damit die Lebensdauer der SSD und erhöht die dauerhafte Schreibrate auf rund 29k – über die garantiere Lebensdauer von fünf Jahren.

Entwicklung und Zukunft bei Flash- und DRAM-Speicher

Mit welcher Entwicklung darf man künftig rechnen? DRAMs gelten als schneller, aber auch flüchtiger Speicher. Flash ist dagegen persistent, aber nicht ganz so schnell. Wird es eine Annäherung der beiden Techniken geben?

Arenz: Ja, davon gehen wir aus. Dies sind aber Zukunftstechnologien, die sich noch in einem frühen Laborstadium befinden. Wir erforschen permanent verschiedenste Technologien. Hier ist aber noch nichts spruchreif und in den kommenden zwei, drei Jahren ist auch mit keiner konkreten Ankündigung zu rechnen.

Wir sehen aber einen Bedarf, die Abgrenzung von Memory und Storage und dem Abfall der Latenz um den Faktor 1.000 zu überbrücken. Wir setzen hier auf den Non-Volatile-Speicher NVDIMM-P. Von den ebenfalls diskutierten NVDIMM-F und NVDIMM-N hat der P-Ansatz den Vorteil, dass der Speicher sowohl als Byte oder als Block adressiert werden kann. Der Zugriff auf gespeicherte Daten soll sich in einem Latenzbereich bewegen, der DRAM entspricht. Interessant ist dies vor allem für In-Memory-Computing. Mit der neuen Technik ist ein schnelles Daten-Flashing in ein Speichermedium gegeben, dass zwar persistent ist, aber auf dem schnellen Memory-Channel sitzt und bei Bedarf auch in einem Bruchteil der Zeit wieder recovert werden kann.

Non-Volatile-DIMM sind zudem schon JEDEC spezifiziert. Wir arbeiten hier mit Netlist als Partner zusammen, der schon eine Zeit lang in diesem Umfeld unterwegs ist. Unser Anspruch ist hier, mehr Kapazität zu bieten als andere. Außerdem sehen wir, dass die Kunden offene Standards bevorzugen. Daher setzen wir bewusst auf JEDEC und nicht auf proprietäre Schnittstellen wir andere Anbieter im Markt (Anm. d. Red.: z.B. 3D-Xpoints). Mit unseren NVDIMMs gibt es keinen Vendor-Lockin, und diese Speichermodule werden in jeden Server passen.

OEMs werden wir vermutlich im zweiten Halbjahr die ersten NVDIMM-Samples zur Verfügung stellen können. Der Channel wird sich dann sicher noch zwei, drei zusätzliche Quartale gedulden müssen, aber das Thema kommt.

- Datacenter: Hohes Einsparpotenzial durch 3D bei DRAM und Flash

- SSD/DRAM: Herausforderung Rechenzentrum

- Einfluss des Flash- oder DRAM-Typ auf den Server

- TSV-DRAMs: schneller und mit höherer Kapazität

- Storage/Server: Bessere SSDs mit 3D-Architektur

- Fünfmal schneller mit NVMe

- Unterschied zwischen Enterprise- und Consumer-SSDs

- Entwicklung und Zukunft bei Flash- und DRAM-Speicher