Virtualisierung im modernen IT-Betrieb – jetzt neu denken

Virtualisierung ist aus modernen IT-Architekturen nicht mehr wegzudenken – sie entlastet Hardware, senkt Betriebskosten und schafft Spielraum für flexible Betriebsmodelle. Doch mit wachsender Komplexität und neuen Lizenzmodellen steigen auch die Anforderungen an Planung, Integration und Betrieb. Für eine zukunftssichere Virtualisierungsstrategie, müssen IT-Manager technische Optionen und wirtschaftliche Rahmenbedingungen sorgfältig abwägen.

Virtualisierung ist aus modernen IT-Architekturen nicht mehr wegzudenken – sie entlastet Hardware, senkt Betriebskosten und schafft Spielraum für flexible Betriebsmodelle. Doch mit wachsender Komplexität und neuen Lizenzmodellen steigen auch die Anforderungen an Planung, Integration und Betrieb. Für eine zukunftssichere Virtualisierungsstrategie, müssen IT-Manager technische Optionen und wirtschaftliche Rahmenbedingungen sorgfältig abwägen.

Vor dem Hintergrund steigender Betriebskosten, zunehmender Umweltbelastung und drohender Ressourcenknappheit spielt Virtualisierung im Rechenzentrum eine zentrale Rolle. Gleichzeitig werden einzelne Systeme immer leistungsfähiger und effizienter. Wo früher ganze Racks mit dedizierten Servern für Web-Anwendungen, IT-Management, Datenbanken oder Kommunikationsdienste benötigt wurden, übernimmt heute oft ein einziger physischer Host diese Aufgaben gleichzeitig. Im Folgenden wird auf Vorteile und Risiken eingegangen. Dieser Beitrag ergänzt als Update die aktuelle Marktübersicht »Virtualisierungslösungen im Überblick« auf speicherguide.de.

Für den parallelen Betrieb unterschiedlicher Betriebssysteme und Anwendungen auf einem einzigen Server wird eine Abstraktionsschicht benötigt: der sogenannte Hypervisor. Ein Hypervisor unterteilt einen physischen Server in mehrere virtuelle Maschinen (VMs) und verwaltet die verfügbaren Hardware-Ressourcen für einen störungsfreien Betrieb der einzelnen VMs. Grundsätzlich wird zwischen zwei Typen von Hypervisoren unterschieden:

● Typ-1-Hypervisoren (Bare-Metal-Hypervisoren) zeichnen sich dadurch aus, dass sie direkt auf der Hardware des physischen Servers laufen – ohne dass ein darunterliegendes Betriebssystem erforderlich ist. Sie kontrollieren die Hardware direkt und verwalten die virtuellen Maschinen. Diese Art von Hypervisor bietet in der Regel eine bessere Performance und höhere Sicherheit. Prominente Beispiele hierfür sind VMware ESXi, Microsoft Hyper-V (Server-Version) und Xen.

● Im Gegensatz dazu benötigen Typ-2-Hypervisoren (Hosted Hypervisoren) ein Host-Betriebssystem als Grundlage, auf dem sie wie eine normale Anwendung ausgeführt werden. Die Verwaltung der virtuellen Maschinen erfolgt dabei über das Host-Betriebssystem. Diese Hypervisoren sind einfacher zu installieren und zu verwenden, gehen jedoch gegenüber Typ-1-Hypervisoren mit Performance-Einbußen einher, da das zusätzliche Host-Betriebssystem selbst auch Ressourcen beansprucht. Oracle VirtualBox ist ein Beispiel eines Typ-2-Hypervisors.

Eine weitere Form von Virtualisierung ist Containerisierung, beispielsweise auf Basis von Docker oder LXC. Dabei teilen sich Anwendungen einen gemeinsamen Betriebssystemkern. In diesem Artikel geht es ausschließlich um Virtualisierung mit VMs.

Virtualisierung: Vorteile und Risiken

Klassisch wurde jede Anwendung auf einem eigenen Server installiert. Das braucht nicht nur viel Platz: die Hardware muss beschafft und für jeden Server muss eine Betriebssystem-Lizenz erworben werden; jedes Rack benötigt zudem einen Switch, Stromverteilung und eine USV. (Grafik: Kerstin Mende-Stief)Virtualisierung löst mehrere Herausforderungen moderner IT-Infrastruktur. Hardware wird konsolidiert, was in erster Linie Stellplatz und Komponenten spart. Aber auch die Kosten für Lizenzen sinken erheblich. Es werden weniger Lizenzen für Betriebssysteme oder Switches benötigt. Die Komplexität sowohl von Netzwerk- als auch Rechenzentrumsinfrastruktur kann minimiert werden.

Klassisch wurde jede Anwendung auf einem eigenen Server installiert. Das braucht nicht nur viel Platz: die Hardware muss beschafft und für jeden Server muss eine Betriebssystem-Lizenz erworben werden; jedes Rack benötigt zudem einen Switch, Stromverteilung und eine USV. (Grafik: Kerstin Mende-Stief)Virtualisierung löst mehrere Herausforderungen moderner IT-Infrastruktur. Hardware wird konsolidiert, was in erster Linie Stellplatz und Komponenten spart. Aber auch die Kosten für Lizenzen sinken erheblich. Es werden weniger Lizenzen für Betriebssysteme oder Switches benötigt. Die Komplexität sowohl von Netzwerk- als auch Rechenzentrumsinfrastruktur kann minimiert werden.

Trägt Virtualisierung tatsächlich dazu bei, dass der Gesamt-Energiebedarf – und damit der Betriebskostenanteil – sinkt? Die Berechnung ist nicht so trivial, wie es auf den ersten Blick scheint. Serverauslastung ist von verschiedenen Faktoren wie CPU- und Speichernutzung, Festplatten-E/A, Art der Anwendung und deren Nutzung, aber auch von der verfügbaren Netzwerkbandbreite und Kühlung abhängig. 2023 ermittelte das Natural Resources Defense Council eine durchschnittliche Serverauslastung zwischen zwölf und 18 Prozent. Server von Meta erreichten bereits 2011 eine Effizienz von 94,5 Prozent.

Rechenbeispiel Energiekosten

Für ein Gedankenexperiment vergleichen wir die Auslastung des Mainstream SuperServer SYS-622B-TRT von Supermicro im klassischen Betrieb (durchschnittliche Last von optimistischen 15%) mit einer virtualisierten Umgebung (realistische 60%). Für das Experiment werden zwölf einzelne Server in drei 19-Zoll-Racks auf drei Virtualisierungs-Hosts in einem Rack konsolidiert. Die maximale Leistungsaufnahme des Servers beträgt 1,2 kW. Der Einfachheit rechnen wir die Last linear zur Leistungsaufnahme um: 100% Ausnutzung entspricht 1,2 kW.

Aktuell liegt der Industriestrompreis in Deutschland bei etwa 16 bis 18 Cent pro Kilowattstunde (kWh). Als Preis setzen wir für unser Gedankenexperiment 17 Cent an. Die jährlichen Kosten im 24x7-Betrieb bei 15 Prozent Auslastung betragen pro Server 268 Euro. Bei zwölf Servern sind es im Jahr 3.216,72 Euro. Das Break-even in unserem Szenario ist mit der Konsolidierung auf drei Server erreicht. Allerdings sparen wir zwei Switches á 52 Watt (Cisco Catalyst WS-C2960S-48TS-L), was einer Ersparnis von 155 Euro bei den Energiekosten entspricht.

In der Praxis sieht das natürlich ganz anders aus: In der Regel werden Anwendungen auf älteren, energiehungrigen Modellen mit neuer Hardware virtualisiert. Moderne Systeme sind leistungsfähiger und energieeffizienter. Würden die zwölf Server aus unserem Gedankenexperiment auf einem einzigen System mit 2,7 kW Leistungsaufnahme konsolidiert, reduzierten sich die jährlichen Energiekosten auf 2.412,50 Euro.

Vorteile von Virtualisierung

Deutlicher als Einsparungen bei den Energiekosten sind technische und administrative Vorteile. Virtualisierung erlaubt es, Systeme schneller bereitzustellen und flexibel zu verschieben – etwa bei Wartungsarbeiten, für Live-Migration zwischen unterschiedlichen Hosts, sowie im Zuge der Disaster-Recovery oder um Lastspitzen auszugleichen. Ein weiterer Anwendungsfall ist die nahtlose Integration von Cloud- und Hybrid-Szenarien, zum Beispiel für die Bereitstellung von Entwicklungs- und Testumgebungen oder ein automatisiertes Failover auf virtuellen Instanzen bei einem Cloud-Anbieter, während Kernsysteme lokal bleiben.

Es gibt allerdings auch Risiken zu berücksichtigen. Bei unzureichender Redundanz oder Ausfall eines Hostsystems können mehrere Dienste gleichzeitig ausfallen. Ein Angriff auf den Hypervisor (Escape-Angriff) kann den Zugriff auf alle VMs ermöglichen. Virtualisierte Umgebungen haben andere Anforderungen an Administration und Verwaltung sowie auch an die Überwachung – andernfalls wächst die Gefahr von Ressourcenengpässen. Auch Lizenzmodelle sind oft komplex und führen ohne umfassende Planung schnell zu (teuren) Lizenzverstößen.

Vor allem ITOM-Werkzeuge (IT Operations & Management) wie Monitoring, Ticketsystem, Integritätschecks oder Automatisierungstools lassen sich hervorragend konsolidieren. Aus Sicherheitsgründen sollten wichtige Werkzeuge wie CMDB, Verzeichnisdienste (AD, LDAP, Kerberos) und Server für die Verwaltung privater Schlüssel (PKI-Server) oder Managementsysteme für vom BSI für bestimmte Einsatzszenarien zugelassener Komponenten (z. B. secunet, genua, Rohde & Schwarz) separat betrieben werden: entweder auf dedizierten Servern oder speziell abgesicherten, eigenen Virtualisierungshosts.

Beschaffungskriterien für Virtualisierungslösung

Die Wahl einer geeigneten Virtualisierungslösung hängt von technischen, organisatorischen und wirtschaftlichen Kriterien ab. Die Beantwortung der folgenden Fragen kann bei der Planung und Beschaffung eines passendes Anbieters helfen:

- Welche Betriebssysteme und VM-Formate werden unterstützt?

- Welche Funktionen werden gebraucht (HA-Features, Live Migration, Snapshots, GPU-Passthrough, Clusterfähigkeit)?

- Gibt es eine intuitive GUI, APIs für Automatisierung und eine zentrale Clusterverwaltung?

- Welche Backup-Methoden werden unterstützt?

- Lässt sich das System nahtlos in die vorhandene Infrastruktur einfügen (Netzwerk, Storage, Identity Management, etc.)?

- Welche Lizenzmodelle und Laufzeiten werden angeboten: Einmalige Lizenz, Subscriptions, CPU-basierte Gebühren, Appliances?

- Welche zusätzlichen Kosten sind zu erwarten für Add-Ons und/oder Support?

- Welche SLA wird angeboten?

- Wie belastbar ist das Partner-Ökosystem bzw. der Support durch den Hersteller?

- Wie schnell reagiert der Hersteller bei Problemen, etwa dem Bekanntwerden von Schwachstellen?

- Wie hoch ist der zu erwartende Schulungsbedarf und -aufwand?

Übersicht relevanter Anbieter

Der Markt für Virtualisierungslösungen ist auch zwei Jahre nach der Übernahme von VMware durch Broadcom noch in Aufruhr. Letzter Grund für die Aufregung im Netz war die Ankündigung, die Mindestanzahl Cores von 16 auf 71 für Neuverträge ab April 2025 anzuheben. Zuvor wurden alle Preismodelle bereits auf Abonnement-Basis gestellt; Lebenszeit-Lizenzen (Perpetual License) und beliebte Produkte wie den Free Hypervisor oder vSphere Essentials kündigte Broadcom ab. 2024 verkaufte Broadcom das End-User Computing (EUC)-Geschäft und mit ihr die VDI-Tool-Suite von Vmware (VMware Horizon) sowie die Management-Plattform Workspace ONE an die Investmentgesellschaft KKR, welche die Sparte in eine eigenständige Organisation – Omnissa – überführte.

Auch in der Partnerlandschaft rumort es. Erst im Juni bestärkte Brian Moats, SVP Global Commercial Sales and Partners bei Broadcom in einem Blogpost den Fokus auf Partner, die »sich dafür einsetzen, mit Vmware-Lösungen ein transformatives Kundenerlebnis zu bieten, was sie durch ihre bisherigen Leistungen, ihr technisches und anderes relevantes Fachwissen sowie ihre Fähigkeit, die notwendigen Investitionen zu tätigen, um den Kunden das erwartete und verdiente Serviceniveau zu bieten, unter Beweis gestellt haben«. Im selben Zug kündigte er die Abschaffung der Registered-Stufe im Broadcom Advantage Partner Program for VMware Resellers an, »da der Großteil der Kundenwirkung und der Geschäftsdynamik von Partnern stammt, die in den drei obersten Stufen [Pinnacle, Premier und Select – Anm. d. Red.] tätig sind.« Gleichzeitig betont Moats, die Messlatte für die verbleibenden Stufen höher zu legen.

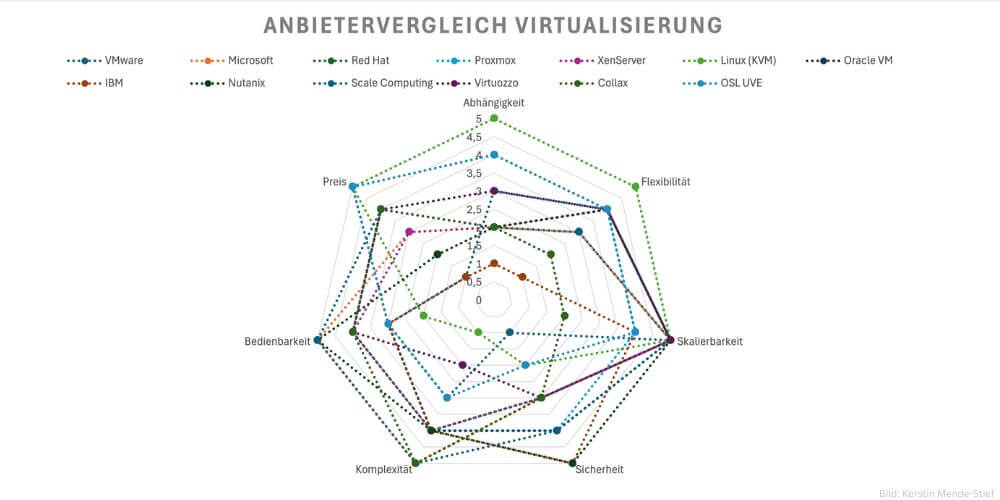

Bei der Auswahl einer Virtualisierungslösung ist es entscheidend, die spezifischen Anforderungen genau zu analysieren. (Grafik: Kerstin Mende-Stief)

Bei der Auswahl einer Virtualisierungslösung ist es entscheidend, die spezifischen Anforderungen genau zu analysieren. (Grafik: Kerstin Mende-Stief)

Migration weg von Vmware fällt vielen schwer

Resellern und Service-Providern, die jahrzehntelang in Wissen, Weiterbildungen und Zertifizierungen investiert haben, dürfte ein Wechsel jedoch nicht leichtfallen. Fachkräfte mit entsprechender Microsoft- oder Linux-Expertise sind rar. Know-How lässt sich zwar aufbauen, dauert aber entsprechend und ist mit neuen Investitionen verbunden. Das können (oder wollen) sich nicht alle leisten. Dabei macht Diversifizierung unabhängiger und das eigene Unternehmen wertvoller für potentielle neue Kunden, die recht bald auf externe Spezialisten angewiesen sein könnten.

Auch die prognostizierte Flucht verärgerter Anwender, weg von VMware hin zu alternativen Angeboten, blieb bisher aus. Ein Grund liegt in der tiefen Verwurzelung von Vmware in vielen Unternehmen und den zahlreichen Integrationen in vSphere, die in der Vielfalt aktuell kein anderer Hersteller anbietet, unter anderem vSAN für software-definierten Speicher, NSX für Netzwerkvirtualisierung und -sicherheit, APIs über das vSphere SDK (Software Development Kit) plus Unterstützung für Kubernetes-Workloads sowie Werkzeuge wie Aria Operations und vCenter.

Alternative Angebote unterstützen oft nur bestimmte VM-Formate oder Betriebssysteme. Oder die Integration mit bestimmten Unternehmensanwendungen bzw. in bestehende Storage- und Netzwerk-Infrastruktur ist so aufwändig, dass selbst die neuen Vmware-Lizenzen immer noch günstiger sind als ein Wechsel. Trotz benutzerfreundlicher, webbasierter Oberflächen kann die Umstellung mit einer hohen Lernkurve für Administratoren verbunden sein.

Wechsel muss gut geplant sein

Ernstzunehmende Konkurrenz gibt es derzeit von Microsoft mit Hyper-V sowie Nutanix, Proxmox, Virtuozzo, Scale Computing oder dem in Deutschland entwickelten Collax V-Cube. Kleinere oder spezialisierte Anbieter können die Widerstandsfähigkeit einer Organisation erheblich steigern.

Ein Wechsel sollte in jedem Fall gut geplant werden. Wechsel in der Preis-, Vertriebs- oder Produktstrategie wie im Fall Broadcom/Vmware kann es bei jedem kommerziellen Anbieter geben. Citrix und Red Hat haben beispielsweise ihre Produktstrategie ebenfalls neu ausgerichtet. Beide Unternehmen verfolgen eine Cloud-First-Strategie und haben ihre Virtualisierungslösungen in andere Produkte integriert bzw. die Entwicklung ganz eingestellt. Andere Anbieter wie Nutanix oder Scale Computing ergänzen Virtualisierungsfunktionen in ihre Plattformen. Echte Unabhängigkeit gibt es bei keinem Angebot – selbst im Open-Source-Umfeld ist man von der Community und der eigenen Expertise abhängig.

Anbieter-Profile: Hier finden sich Hinweise zu Vor- und Nachteilen der unterschiedlichen Virtualisierungslösungen sowie den jeweils optimalen Einsatzszenarien.