Netskope: Schatten-KI verdoppelt Datenlecks & Policy-Verstöße

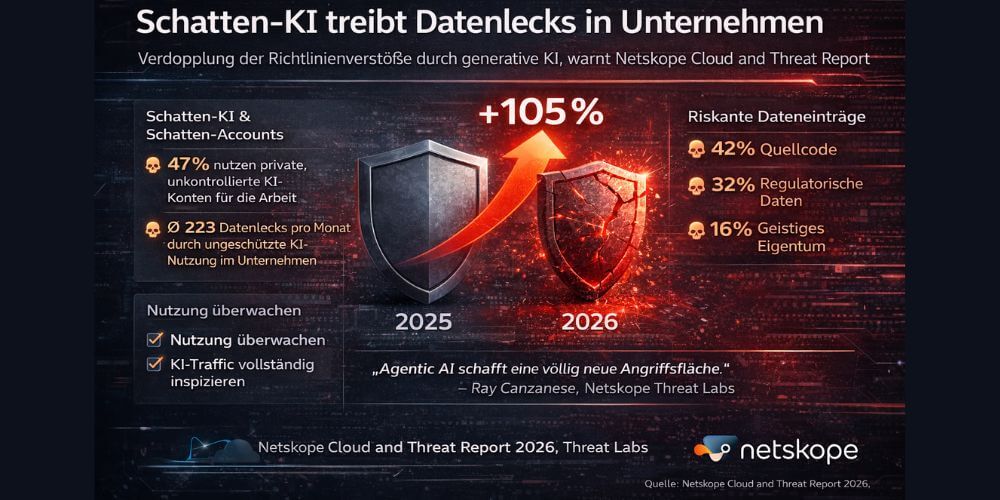

Die Nutzung generativer KI nimmt in Unternehmen rasant zu – doch Sicherheitskonzepte halten nicht Schritt. Laut Netskope Cloud & Threat Report 2026 haben sich Verstöße gegen Datenrichtlinien im Zusammenhang mit KI innerhalb eines Jahres mehr als verdoppelt. Schatten-KI und unkontrollierte Datenflüsse entwickeln sich zu einem zentralen Sicherheitsrisiko.

Die Nutzung generativer KI nimmt in Unternehmen rasant zu – doch Sicherheitskonzepte halten nicht Schritt. Laut Netskope Cloud & Threat Report 2026 haben sich Verstöße gegen Datenrichtlinien im Zusammenhang mit KI innerhalb eines Jahres mehr als verdoppelt. Schatten-KI und unkontrollierte Datenflüsse entwickeln sich zu einem zentralen Sicherheitsrisiko.

Der aktuelle Cloud & Threat Report 2026 von Netskope Threat Labs zeichnet ein klares Bild: Generative KI ist in der Breite der Unternehmen angekommen – allerdings häufig außerhalb kontrollierter Strukturen. Während sich die Zahl der Nutzer von SaaS-basierten GenAI-Anwendungen innerhalb eines Jahres verdreifacht hat, stieg die tatsächliche Nutzungstiefe noch deutlich stärker. Die Anzahl der an KI-Systeme gesendeten Prompts nahm um den Faktor sechs zu.

Parallel dazu wuchs die Angriffsfläche. Die Zahl der datenschutzrelevanten Richtlinienverstöße im Zusammenhang mit KI-Anwendungen hat sich gegenüber dem Vorjahr mehr als verdoppelt. Der Versuch vieler Unternehmen, den Einsatz von KI über offiziell bereitgestellte Tools zu steuern, zeigt bislang nur begrenzte Wirkung.

Schatten-KI bleibt der dominierende Risikofaktor

Ein zentrales Ergebnis des Reports ist die anhaltend hohe Nutzung privater KI-Konten für geschäftliche Zwecke. Rund 47 Prozent der Anwender greifen weiterhin auf private Accounts zurück, etwa bei Chatbots oder Cloud-basierten KI-Diensten.

Diese Schatten-KI führt im Durchschnitt zu 223 sicherheitsrelevanten Vorfällen pro Unternehmen und Monat, bei denen sensible Daten an KI-Anwendungen übertragen werden. Besonders alarmierend ist die Situation im oberen Viertel der untersuchten Organisationen: Dort liegt die Zahl bei mehr als 2.100 Vorfällen monatlich.

Sensible Daten im Fokus der KI-Nutzung

Die Analyse zeigt auch, welche Informationen besonders häufig in KI-Systeme eingespeist werden:

- Quellcode: 42 Prozent

- Regulatorisch geschützte Daten: 32 Prozent

- Geistiges Eigentum: 16 Prozent

Mehr als die Hälfte aller Verstöße gegen Datenrichtlinien betrifft regulierte Inhalte wie Finanz-, Gesundheits- oder personenbezogene Daten. Damit entwickelt sich der Einsatz generativer KI zunehmend zu einem Compliance- und Haftungsthema.

Plattformverschiebung bei KI-Diensten

Auch die genutzten KI-Plattformen verändern sich. Google Gemini verzeichnete laut Report ein starkes Wachstum und steigerte seine Nutzung in Unternehmen von 46 auf 69 Prozent. Netskope erwartet, dass Gemini im ersten Halbjahr 2026 ChatGPT als meistgenutzte KI-Plattform im Unternehmensumfeld ablösen könnte.

Diese Dynamik erschwert zusätzlich die Governance, da Sicherheitsrichtlinien und Kontrollmechanismen mit der Geschwindigkeit der Plattformwechsel kaum Schritt halten.

Schatten-KI und Agentic AI erschaffen völlig neue Angriffsflächen. (Quelle: Netskope)

Schatten-KI und Agentic AI erschaffen völlig neue Angriffsflächen. (Quelle: Netskope)

Agentic AI und MCP erweitern die Angriffsfläche

Mit Blick auf 2026 warnt Netskope vor einer neuen Eskalationsstufe durch Agentic AI. Dabei handelt es sich um KI-Systeme, die eigenständig komplexe Aufgaben ausführen und dabei auf unterschiedliche Unternehmensressourcen zugreifen.

»Agentic AI schafft eine völlig neue Angriffsfläche«, sagt Ray Canzanese, Director der Netskope Threat Labs. »Wenn autonome Agenten Zugriff auf interne Daten erhalten, können Fehlkonfigurationen oder bösartige Prompts zu massiven Datenabflüssen in Millisekunden führen.«

Zusätzliche Risiken entstehen durch KI-gestützte Browser sowie das Model Context Protocol (MCP), das den Austausch von Kontextinformationen zwischen Modellen standardisiert und damit neue, schwer kontrollierbare Datenpfade eröffnet.

Handlungsempfehlungen für Unternehmen

Der Report leitet daraus vier zentrale Maßnahmen ab:

- Vollständige Inspektion: Durchgängige Analyse des gesamten HTTP- und HTTPS-Traffics, einschließlich KI-bezogener Kommunikation.

- Strikte App-Governance: Blockieren von KI-Tools ohne klaren geschäftlichen Nutzen oder mit erhöhtem Risikoprofil.

- Konsequente DLP-Strategie: Schutz von Quellcode, Zugangsdaten und sensiblen Inhalten vor der Weitergabe an KI-Modelle.

- Isolation risikoreicher Zugriffe: Einsatz von Remote Browser Isolation für neue oder unbekannte Domains und KI-Dienste.

Generative KI ist operativer Alltag

Der Netskope Cloud & Threat Report 2026 macht deutlich: Generative KI ist kein Zukunftsthema mehr, sondern operativer Alltag – allerdings mit Sicherheitsmodellen aus der Vergangenheit. Ohne klare Governance, technische Durchsetzung und Transparenz droht KI vom Produktivitätshebel zum strukturellen Sicherheitsrisiko zu werden.