Die Zetabyte-Ära ist da: Was darf Storage kosten?

Daten sind zum wichtigsten Unternehmensgut geworden. Entsprechend ist die Speicherinfrastruktur ein wesentlicher Bestandteil der meisten IT-Budgets. In ihrem aktuellen Report Storage Outlook versuchen die Marktbeobachter von Horison Information Strategies ein detaillierteres Bild zu zeichnen.

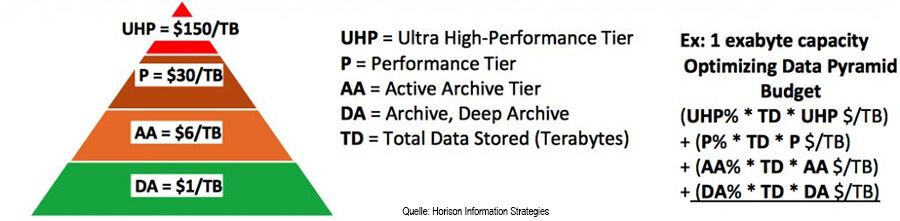

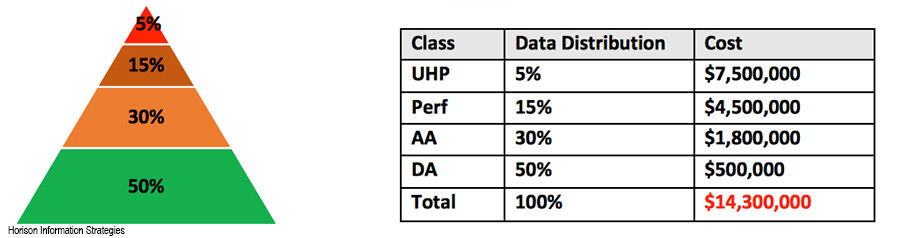

Storage-Tiering ist für sie dabei eine Schlüsselstrategie. Sie sorgt für eine maximale Auslastung der Speicher-Ressourcen, die optimale Nutzung der verfügbaren Speicherlösungen für jede Datenklasse und schlussendlich Kostensenkungen.

Archive wachsen überproportional

IDC schätzt, dass die installierte Speicherkapazität zwischen 2019 und 2024 jährlich um durchschnittlich 17,8 Prozent wächst, in konkreten Zahlen von 5,8 auf 13,2 ZByte. Die Datenmenge selbst soll um 20,4 Prozent jährlich von 3,5 auf 8,9 ZByte wachsen. Große Mengen des installierten Speichers werden also nicht genutzt.

Darüber hinaus sind heute schätzungsweise über 60 Prozent aller Daten archiviert und könnten bis 2024 80 Prozent oder mehr erreichen. Dies soll einem Jahresumsatz von elf Milliarden US-Dollar entsprechen. Damit sind Archivdaten bei weitem die größte Speicherklasse. Angesichts dieser Entwicklung, so die Analysten, müsse sich das traditionelle Speicherhierarchie-Paradigma anpassen.

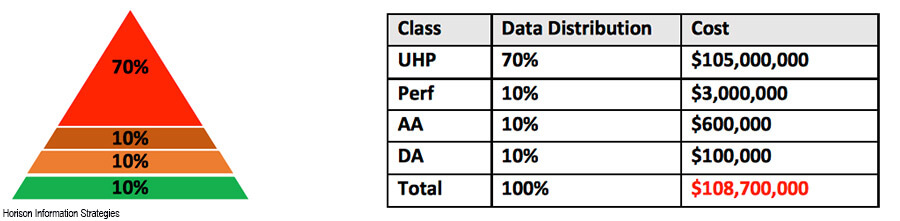

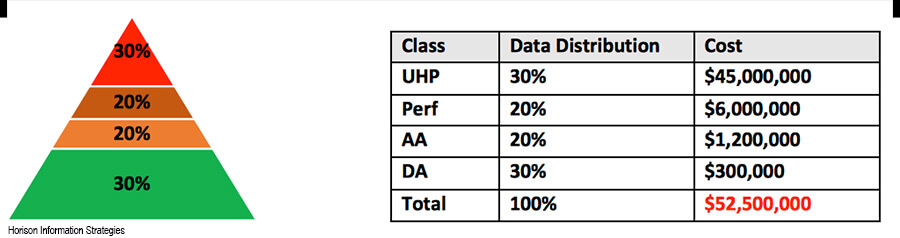

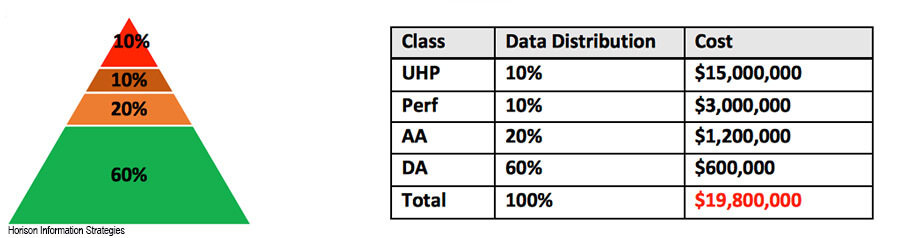

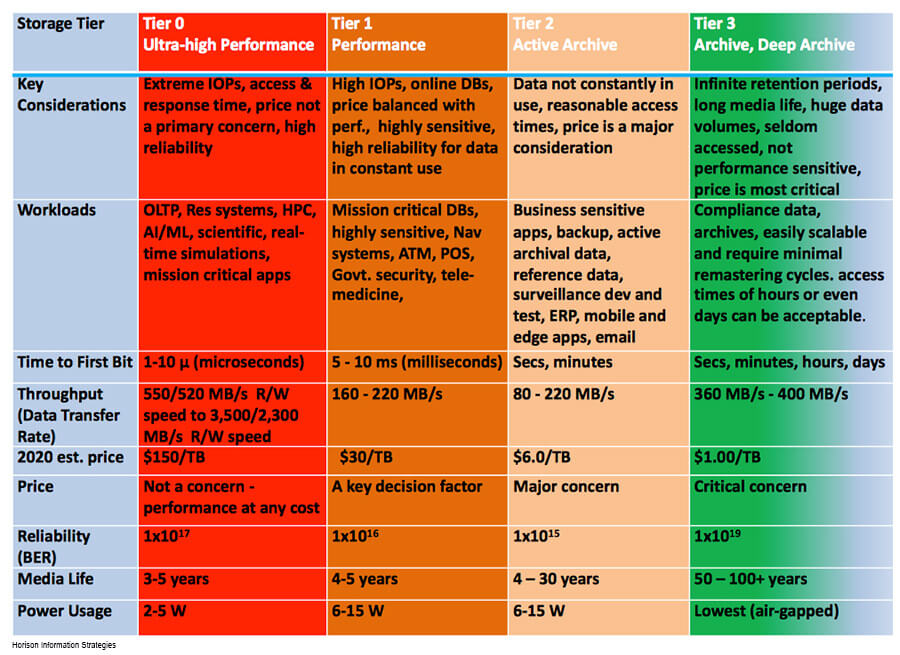

Entsprechend empfehlen die Experten für Unternehmen ein vierstufiges Speicherklassenmodell: Von »Ultra-High Performance« bis zum »Deep Archive« (siehe Abb.) – mit entsprechend ausgewogenen Kostenstrukturen. Hier beispielhaft an der Verteilung eines EByte:

Was dieses Schema im Mittel zeigt, brechen die Analysten weiter nach Unternehmensschwerpunkt und Workloads auf (Quelle: Horison).

Was dieses Schema im Mittel zeigt, brechen die Analysten weiter nach Unternehmensschwerpunkt und Workloads auf (Quelle: Horison).

Heavy-Computing-Workloads (HPC)

Charakteristisch sind Tausende von Servern in einem Cluster auf Hochleistungsspeichersystemen. Rechenintensive Anwendungen, die einen schnellen Direktzugriff erfordern, Blockspeicher für die Mustererkennung, die zukünftige Szenarien simulieren und Ergebnisse vorhersagen. HPC-Organisationen verwenden umfangreiche Analysedienste (OLAP), um die enormen Datenmengen in komplexen Hybridumgebungen zu verstehen.

Heavy-Computing-Workloads (Quelle: Horison).

Heavy-Computing-Workloads (Quelle: Horison).

Transaktions-fokussierte Umgebungen

Diese Workloads sind reaktionszeitkritische Geschäftsprozesse wie OLTP, Echtzeitkommunikation, Reservierungssysteme, Auftragsabwicklung, die für umfangreiche Lese-, Schreib- und Aktualisierungsvorgänge in kleinen Datensätzen optimiert sind. Als Beispiel dient die Finanzbranche, die umfangreiche, transaktionsbasierte Dienste für Online-Banking-Transaktionen, Geldautomaten, POS, Kreditkartengebühren, Prüfungs- und Kommunikationsprotokolle nutzt.

Transaktions-fokussierte Umgebungen (Quelle: Horison).

Transaktions-fokussierte Umgebungen (Quelle: Horison).

Datenbankgetriebene Workloads im Rechenzentrum

Dies ist die häufigste Art von Datenverteilungsmodellen: Der Standard-Datenbank-Workload muss optimiert und verwaltet werden. Dies soll den Dienst unterstützen, der diese Daten verwendet. Das Gesundheitswesen und die Biowissenschaften nutzen Datenbanken für elektronische Patientenakten, Bilder (Röntgen, MRT oder CT), Genomsequenzen, Aufzeichnungen über die pharmazeutische Entwicklung und Zulassung, die zu diesem Profil passen.

Datenbankgetriebene Workloads im RZ (Quelle: Horison).

Datenbankgetriebene Workloads im RZ (Quelle: Horison).

Batch-Workloads bzw. Business-Support-Aktivitäten

Diese Workloads sind häufig so konzipiert, dass sie im Hintergrund ausgeführt werden und tendenziell größere, sequenzielle Datenmengen verarbeiten. Im Allgemeinen sind Batch-Workloads selten zeitkritisch und werden regelmäßig ausgeführt. Beispiele hierfür sind tägliche Berichte aus ERP, Inventar, E-Mail, Gehaltsabrechnung, monatliche oder vierteljährliche Abrechnungen oder das Zusammenstellen der Ergebnisse monatelanger Online-Berichte. Die Versicherung verarbeitet viele Langzeitunfallaufzeichnungen und -bilder, gesundheitsbezogene Angaben, Streitigkeiten und Zahlungsverläufe im Batch-Modus. Diese Workloads erfordern bei Verwendung möglicherweise erhebliche Rechen- und Speicher-Ressourcen.

Batch-Workloads bzw. Business-Support-Aktivitäten (Quelle: Horison).

Batch-Workloads bzw. Business-Support-Aktivitäten (Quelle: Horison).

Datenintensive Arbeitslasten (Heavy Archives)

Datenintensive Anwendungen verwenden den größten Teil ihrer Prozessorkapazität für I/O-Operationen und das Verschieben und Bearbeiten von Daten, da Suchzeiten und Datenübertragungsgeschwindigkeiten ihre Leistung einschränken. Beispielsweise ist die M&E-Branche stark auf digitale Archive angewiesen, da sie Rohproduktionsmaterial bereitstellen. Bei der Filmproduktion ist es üblich, dass Workflows zu einem bestimmten Zeitpunkt nach der Erstellung des Films Zugriff auf archivierte digitale Assets benötigen. Die meisten M&E-Inhalte werden niemals gelöscht. Überwachung, Medizin, Finanzen, Regierung, physische Sicherheit und soziale Medien passen ebenfalls zu diesem Modell.

Datenintensive Arbeitslasten (Quelle: Horison).

Datenintensive Arbeitslasten (Quelle: Horison).

Storage-Innovationen stehen aus

Die Analysten sehen in Hyperscale Datacentern die schnellst wachsende Gruppe mit der höchsten Relevanz für den Speichermarkt, schließlich vereinen sie Compute, Storage, Backup, Archivierung und Cloud. Auch im Bereich Deep-Archive erwarten die Marktforscher großes Wachstum und Dynamik.

Aber Innovation? Es wird kritisch angemerkt, dass Entwicklungen wie Multi-Layer Photonik-Speicher, Quarz-Glas-Medien, holografischer Speicher oder der Einsatz der Quantenphysik es zwar regelmäßig in die Schlagzeilen schaffen, aber bislang nicht wirklich den Weg aus dem Lab ins Rechenzentrum geschafft haben.

Für die Analysten von Horison Information Strategies heißt dies: Die Speicher-Branche ist hungrig nach neuen, innovativen Hardware- und Software-Lösungen, die die Spielregeln ändern können.

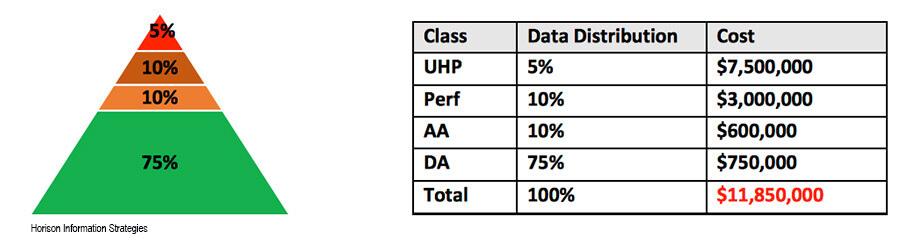

Vierstufiges Speichermodell - Schlüsselmerkmale und zukünftige Anforderungen (Quelle: Horison).

Vierstufiges Speichermodell - Schlüsselmerkmale und zukünftige Anforderungen (Quelle: Horison).