Bitkom: KI macht Druck auf Deutschlands Rechenzentren

KI und Cloud treiben den Ausbau der Rechenzentren in Deutschland. Laut Bitkom und dem Borderstep Institut wächst die IT-Anschlussleistung 2025 auf 2,98 GW, überschreitet Anfang 2026 die 3-GW-Marke und peilt bis 2030 5 GW an. KI-Kapazitäten vervierfachen sich auf 2,02 GW (40 %). Frankfurt bleibt der deutsche RZ-Hub. Engpässe erwartet die Studie bei Energiepreisen, Netzen und Genehmigungen.

KI und Cloud treiben den Ausbau der Rechenzentren in Deutschland. Laut Bitkom und dem Borderstep Institut wächst die IT-Anschlussleistung 2025 auf 2,98 GW, überschreitet Anfang 2026 die 3-GW-Marke und peilt bis 2030 5 GW an. KI-Kapazitäten vervierfachen sich auf 2,02 GW (40 %). Frankfurt bleibt der deutsche RZ-Hub. Engpässe erwartet die Studie bei Energiepreisen, Netzen und Genehmigungen.

Der Befund ist deutlich: KI-Workloads und Cloud-Angebote sind der neue Taktgeber des Rechenzentrums-Ausbaus. Nach Angaben von Bitkom und Borderstep Institut stehen KI-Rechenzentren aktuell für rund 15 Prozent der in Deutschland installierten Leistung, bis 2030 sollen es 40 Prozent sein. Die dafür genannte IT-Anschlussleistung steigt von derzeit 530 MW auf prognostizierte 2.020 MW. Parallel klettert die gesamte Datacenter-Leistung 2025 auf 2,98 GW, die 3-GW-Marke fällt Anfang 2026. Bis 2030 stehen 5 GW im Raum, womit sich die Kapazitäten gegenüber 2024 nahezu verdoppeln würden. Für Planer, Betreiber und Beschaffer in mittleren bis großen Umgebungen zeichnet sich damit ein Investitions- und Konsolidierungszyklus ab, der Standortwahl, Energie-Beschaffung, Kühlstrategie und Netz-Anbindung neu gewichtet. Zu diesem Ergebnis kommt die Bitkom-Studie »Rechenzentren in Deutschland: Aktuelle Marktentwicklungen – Update 2025«.

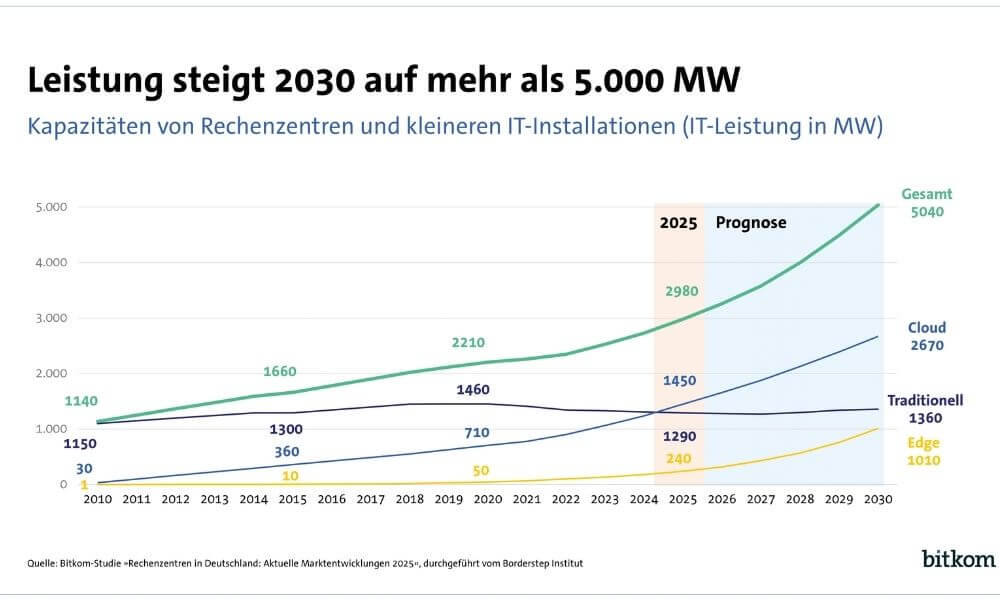

Anfang 2026 soll erstmals die Marke von 3.000 Megawatt und 2030 von 5.000 Megawatt überschritten werden. (Quelle: Bitkom)

Anfang 2026 soll erstmals die Marke von 3.000 Megawatt und 2030 von 5.000 Megawatt überschritten werden. (Quelle: Bitkom)

Server werden effizienter, aber Energiebedarf steigt

Auch der Strombedarf der Rechenzentren in Deutschland ist gestiegen – und wird beispielsweise mit Blick auf die wachsende Bedeutung künstlicher Intelligenz weiter steigen. Er wird 2025 bei 21,3 Mrd. Kilowattstunden liegen – 2024 waren es 20 Mrd. kWh und 2015 noch 12 Mrd. kWh. Rund zwei Drittel des Strombedarfs entfallen dabei auf die IT-Infrastruktur der Rechenzentren, also Server, Speicher und Netzwerktechnik. Das übrige Drittel entfällt auf die Gebäudeinfrastruktur, die Kühlung oder die Gewährleistung einer unterbrechungsfreien Stromversorgung. Die verwendeten IT-Systeme werden dabei immer effizienter.

Beispielsweise stieg die Energieeffizienz bei Standardservern in den Jahren 2017 bis 2022 um jährlich 26 Prozent. »Die Energieeffizienz von Rechenzentren hat in den vergangenen Jahren deutlich zugenommen, und sie wird angesichts steigender Stromkosten und wachsender Anforderungen durch KI weiter an Bedeutung gewinnen«, meint Dr. Rohleder. »Es liegt im ureigenen Interesse der Betreiber, den Stromverbrauch zu optimieren. Effizientere IT-Systeme und Gebäudetechnik senken nicht nur die Kosten, sondern schonen auch die Umwelt. Energieeffizienz ist nicht nur ein technisches Ziel, sondern ein entscheidender Wettbewerbsfaktor.«

Deutscher RZ-Schwerpunkt im Raum Frankfurt

Der Markt ist breit, aber nicht gleichmäßig verteilt. Gezählt werden derzeit rund 2.000 Standorte über 100 kW, darunter etwa 100 Anlagen mit mehr als 5 MW. Die größten hundert Rechenzentren liefern bereits die Hälfte der nationalen Leistung. Unangefochtener Schwerpunkt ist der Raum Frankfurt mit gut 1,1 GW, flankiert von Bayern und Nordrhein-Westfalen. Dass Frankfurt mit rund 14 Prozent pro Jahr am schnellsten wächst, überrascht kaum. Die Nähe zum DE-CIX, die dichte Carrier- und Colocation-Landschaft sowie ein reifes Partner-Ökosystem übersetzen sich hier schlicht in niedrigere Latenz- und Integrationskosten. Interessant ist die tektonische Verschiebung: Das Rhein-Main-Ökosystem dehnt sich nach Rheinland-Pfalz und Bayern aus, während Berlin-Brandenburg als zweiter Hub sichtbar zulegt. Brandenburgs Projektpipeline um 888 MW und Pläne mit dreistelligen Megawattwerten in Rheinland-Pfalz und Mecklenburg-Vorpommern deuten einen Balance-Akt zwischen Konnektivität, Flächenverfügbarkeit und Stromzugang an. Das diskutierte 1-GW-Vorhaben in Dummerstorf zeigt, wohin die Reise gehen soll. Oder zumindest gehen könnte, wenn Planungsrecht, Netzausbau und lokale Akzeptanz zusammenspielen.

Effizienter, aber hungriger: KI treibt den Strombedarf nach oben

Treiber Nummer eins bleibt »Cloud-Computing« für KI und klassische Dienste. Cloud-Infrastrukturen steigen 2025 um rund 17 Prozent auf 1.450 MW und machen damit knapp die Hälfte der Kapazitäten aus. Edge-Rechenzentren gewinnen Dynamik, liegen mit etwa 240 MW aber noch auf kleinem Sockel. Klassische Enterprise-Rechenzentren bleiben wichtig, zeigen jedoch einen rückläufigen Trend. Die Botschaft dahinter ist nüchtern: Latenz-sensible Workloads rücken näher an den Nutzer, alles andere wandert in skalierbare, hochverdichtete Umgebungen – und KI beschleunigt diese Trennung.

Technisch wird effizienter gearbeitet, die absolute Last steigt dennoch. Der Großteil entfällt weiterhin auf Server, Storage und Netz, die Gebäudeinfrastruktur folgt wegen Kühlung und USV. Effizienzgewinne bei Standard-Servern dämpfen den Anstieg, kompensieren aber die KI-bedingten Leistungsdichten nicht. Konsequenz: Kühlkonzepte, Strompfade und Abwärme-Nutzung rücken ins Zentrum der Planung, PUE und Betriebskosten bleiben die Taktgeber.

Dr. Bernhard Rohleder, Bitkom»Künstliche Intelligenz wird zum entscheidenden Faktor für die Leistungsfähigkeit unserer Wirtschaft und unserer Verwaltung«, sagt Bitkom-Hauptgeschäftsführer Dr. Bernhard Rohleder. »Deutschland muss sicherstellen, dass wir über ausreichend leistungsfähige Rechenzentren verfügen. Ohne Rechenzentren keine KI. Nur so können wir unsere digitale Souveränität stärken und zu den internationalen Technologieführern aufschließen.«

Dr. Bernhard Rohleder, Bitkom»Künstliche Intelligenz wird zum entscheidenden Faktor für die Leistungsfähigkeit unserer Wirtschaft und unserer Verwaltung«, sagt Bitkom-Hauptgeschäftsführer Dr. Bernhard Rohleder. »Deutschland muss sicherstellen, dass wir über ausreichend leistungsfähige Rechenzentren verfügen. Ohne Rechenzentren keine KI. Nur so können wir unsere digitale Souveränität stärken und zu den internationalen Technologieführern aufschließen.«

Regulatorik bremst, USA/China enteilen – Handlungsdruck für Betreiber

Kontrovers wird es bei den Rahmenbedingungen. Bitkom fordert »verbesserte regulatorische Rahmenbedingungen, schnellere Planungs- und Genehmigungsverfahren sowie günstigen Strom«. Aus Betreibersicht ist das plausibel. Gleichzeitig stehen deutsche Sonderwege mit dem Energieeffizienzgesetz in der Kritik, Stichworte PUE-Vorgaben und Abwärme-Quoten. Wo die Studie »Harmonisierung« mit EU-Vorgaben anmahnt, riecht es nach Zielkonflikt: Kommunale Wärmeplanung, reale Abnehmer für 30- bis 40-Grad-Abwärme und die Taktung von Netzausbauten lassen sich nicht über Nacht herbeiregulieren. Steuerliche Anreize für Abwärme-Abnehmer wären ein Ansatz, lösen aber weder die Topologie-Frage des Wärmenetzes noch die zeitliche Kopplung von IT- und Energie-Infrastruktur. Leicht sarkastische Randnotiz: Wer gleichzeitig ultraschnell genehmigen, europaweit harmonisieren, Netze ausbauen und Strompreise senken will, sollte sich nicht über Terminpläne wundern, die klingen wie Wunschzettel.

Der internationale Vergleich fällt ernüchternd aus. Die USA und China ziehen davon. Genannt werden 38 GW IT-Anschlussleistung in China und 48 GW in den USA im Jahr 2024. Allein die zehn größten US-Rechenzentren sollen in Summe die Leistung aller 2.000 deutschen Standorte erreichen. Hyperscaler-Vorhaben wie Meta »Hyperion« oder KI-Cluster von OpenAI und xAI illustrieren die Größenordnung, in der dort geplant wird – Hunderttausende bis zur Million spezialisierter GPUs als Zielmarke. Vor diesem Hintergrund klingt der deutsche Fahrplan zu 5 GW bis 2030 solide, aber eben auch bescheiden. Der Abstand vergrößert sich, wenn die heimische Projektliste in Engpässen bei Flächen, Netzknoten und Energiepreisen stecken bleibt.

»Die USA und China legen die Messlatte extrem hoch«, erklärt Dr. Rohleder. »Wenn Deutschland und Europa mithalten wollen, ist es höchste Zeit, gegenzusteuern. Die Bundesregierung sollte daher umgehend die angekündigte Rechenzentrumstrategie mit konkreten Maßnahmen vorlegen.«

Rechenzentren: Standortentscheidungen sind Energie- und Netzfragen

Was folgt daraus für Betreiber und Entscheider in Rechenzentrums- und IT-Abteilungen? Erstens, Standortentscheidungen sind Energie- und Netzfragen. Ohne frühzeitige Klärung von Strom-Kontingenten, Trafo-Kapazitäten und Einspeisepunkten drohen Verzögerungen, die jede Hardware-Roadmap überholen. Zweitens, Abwärme-Nutzung wird vom Nice-to-have zum Kosten- und Lizenzfaktor. Wo realistische Abnehmer fehlen, ist die beste Effizienzstrategie wertlos. Drittens, Liquid-Cooling und Rack-Densities jenseits von 30 kW je Rack werden zum Standard-Werkzeugkasten für KI-Lasten, selbst in Colocation-Umgebungen. Viertens, Edge-Designs gehören in Ausschreibungen, wenn Latenz und lokale Datenhaltung zählen. Fünftens, Beschaffung und Architektur sollten zwei Pfade abbilden: kurzfristig GPU-fähige Kapazität für KI-Pilotierung, mittelfristig eine konsolidierte Plattform, die sowohl Cloud-Anbindung als auch On-Prem-Souveränität ermöglicht.

Bleibt die politische Dimension. Forderungen nach »wettbewerbsfähigen Energiekosten« und »weniger Bürokratie« sind erwartbar. Entscheidend wird sein, ob Bund und Länder den Spagat zwischen Investitionssicherheit und Umwelt-Zielen glaubhaft schaffen. Ohne starken Netzausbau und belastbare Wärme-Konzepte bleibt jeder Mega-Park nur eine schöne Visualisierung. Oder, um Bitkom-Chef Dr. Rohleder zu zitieren: »Ohne Rechenzentren keine KI.« Die Ergänzung aus Betreiber-Sicht lautet allerdings: Ohne planbare Energie- und Genehmigungs-Pfade keine Rechenzentren.