Graid SupremeRAID: GPU-RAID-Controller für High-End-Workloads

Mit SupremeRAID bietet Graid Technology eine GPU-beschleunigte RAID-Karte, die Berechnungen auf die GPU auslagert. Dies soll traditionelle Engpässe klassischer Hardware-Controller umgehen. Das NVMe-RAID-System adressiert datenintensive Workloads wie KI, Big-Data oder HPC und ist für Cloud, Edge, Workstations und GPU-Server verfügbar.

Mit SupremeRAID bietet Graid Technology eine GPU-beschleunigte RAID-Karte, die Berechnungen auf die GPU auslagert. Dies soll traditionelle Engpässe klassischer Hardware-Controller umgehen. Das NVMe-RAID-System adressiert datenintensive Workloads wie KI, Big-Data oder HPC und ist für Cloud, Edge, Workstations und GPU-Server verfügbar.

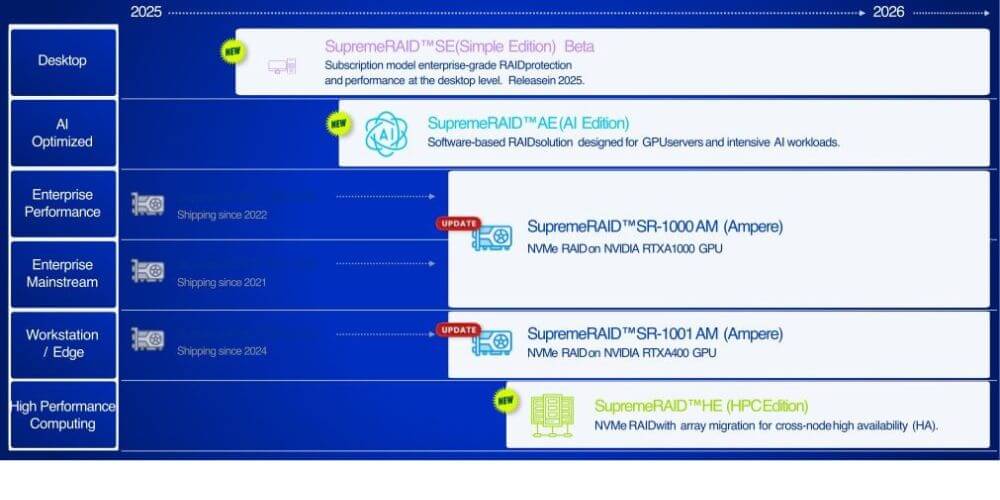

Mit dem exponentiellen Anstieg datenhungriger Workloads (KI, Big-Data) stehen moderne IT-Infrastrukturen vor der Herausforderung, die geforderte hohe Performance zu gewährleisten. Graid Technology will mit seinen GPU-basierten Controllern zur Auslagerung von RAID-Operationen beitragen, das Potential von NVMe-SSDs vollumfänglich auszuschöpfen und die Leistungsfähigkeit moderner Hochleistungsanwendungen signifikant zu steigern. Seit der Gründung wurden verschiedene SupremeRAID-Produkte für Cloud- und Enterprise-Server eingeführt. Seit 2024 gibt es auch eine Version für Tower- und Edge-Server sowie für professionelle Workstations. Bis 2026 sind neue Produkte und Updates geplant. Auf der IT Press Tour im Juni stellte das Unternehmen in Palo Alto, Kalifornien, die Roadmap für die nächsten eineinhalb Jahre vor.

Bereits jetzt ist SupremeRAID SE (Simple Edition) mit Enterprise-Grade RAID-Schutz und -Leistung für Desktops als Beta-Abonnementmodell verfügbar. Diese vereinfachte RAID-Konfiguration unterstützt bis zu acht NVMe SSDs und nutzt vorhandene GPUs für eine hochperformante und zuverlässige Speicherung. Dies ist laut Hersteller vorteilhaft für Video- und Postproduktion, Datenanalyse und Dateiverwaltung, 3D-Rendering und Animation, visuelle Effekte und Spieldesign sowie Grafikdesign und CAD-Workflows. Weitere Editionen speziell für KI- und HPC-Workloads stehen auf der Roadmap.

Die SupremeRAID-Technologie unterstützt PCIe Gen3, Gen4 und Gen5 mit bis zu 32 nativen NVMe-Laufwerken. Der Vertrieb der Produkte erfolgt indirekt. Dazu hat das Unternehmen mit Hauptsitz im Silicon Valley ein Netzwerk von Partnern, OEMs, Distributoren und Wiederverkäufern aufgebaut, darunter renommierte Hersteller wie Supermicro, NVIDIA, Dell Technologies, KIOXIA, Intel und GIGABYTE. Globale Forschung und Entwicklung sind in Taiwan angesiedelt.

GPU-beschleunigtes NVMe-RAID für moderne Workloads

Die gegenwärtige Ära der Hochleistungsdatenverarbeitung wird zunehmend von GPU-beschleunigten Systemen geprägt, wie Jensen Huang, CEO von Nvidia, auf der GTC 2025 betonte. Auch Graid-Gründer Leander Yu ist überzeugt: »Die nächste HPC-Ära gehört dem GPU-beschleunigten Speicher.«

In der Vergangenheit fokussierte sich Graid auf Enterprise-Infrastruktur. Die jetzt angekündigten Produkte wie das SupremeRAID AE (AI Edition) wurden speziell für GPU-Server und datenintensive Workloads entwickelt. Vor diesem Hintergrund erhält auch das Legacy-Produkt ein komplettes Makeover: Die als M-Serie angekündigten Nachfolger der SR-1000 bzw. SR-1001 haben einen Single-Slot-Formfaktor für verbesserte Server-Kompatibilität und sind auf die nächste Generation Ampere GPUs von Nvidia ausgerichtet. Zudem wird es nur noch eine Server-Variante geben. Der Unterschied zwischen Mainstream und Performance entfällt. Das nächste Update der Software (Software-Release 1.7) bietet eine neue grafische Benutzeroberfläche (GUI), eine Restful API für eigene Integrationen, verbesserte Resilienz-Funktionen wie Journaling, Bad Block Detection und einen verbesserten Error Retry Mechanismus. Für 2026 ist zudem eine HPC-Edition mit NVMe-RAID und Array-Migration für Cross-Node-Hochverfügbarkeit geplant.

Die Graid SupremeRAID-Editionen im Überblick (Grafik: Graid)

Die Graid SupremeRAID-Editionen im Überblick (Grafik: Graid)

Die AE-Edition wurde für GPU-Server und intensive KI-Workloads konzipiert. Mit dem Nvidia GPUDirect Storage (GDS) lassen sich NVMe-SSDs direkt an den GPU-Speicher anbinden, um I/O-Engpässe zu vermeiden und nahezu latenzfreie Datenzugriffe zu ermöglichen. Dies soll für eine spürbare Beschleunigung von KI-Trainings- und Inferenzprozessen sorgen. Mit der integrierten Intelligent Data Offload Engine lässt sich die GPU-Auslastung durch effiziente Verteilung der Arbeitslast optimieren. Je nach den spezifischen Workload-Anforderungen werden sowohl virtuelle (shared) als auch dedizierte GPUs unterstützt. Enterprise-Grade Data Protection sorgt für Datenintegrität und Ausfallsicherheit. Zudem wird NVMe-oF unterstützt, was skalierbare Speicherlösungen über Hosts hinweg für große KI-Datensätze ermöglicht. Des Weiteren werden für eine größtmögliche Clustering-Kompatibilität verschiedene Dateisysteme wie BeeGFS, Lustre und Ceph unterstützt, ohne dass eine Datenmigration erforderlich ist.

In Benchmarks erreichte SupremeRAID AE über 95 Prozent der nativen NVMe-Performance, auch bei aktiviertem RAID-Schutz. Bei einem typischen Testaufbau mit Supermicro-Servern, Intel Xeon-CPUs, NVIDIA H100-GPUs und Samsung PM1743 NVMe-Drives zeigte das System bei 128K Random Reads eine Durchsatzleistung von 104 GiB/s und bei 128K Random Writes 43 GiB/s. Die Implementierung belegt lediglich sechs Streaming-Multiprozessoren einer GPU, sodass der Großteil der GPU-Ressourcen für KI-Workloads verfügbar bleibt.

SupremeRAID für Hochleistungsumgebungen

Die SupremeRAID HE Edition adressiert den High-Performance-Computing-Sektor (HPC) mit Fokus auf Cluster-Umgebungen für Daten- und Workload-Parallelisierung wie anspruchsvolle wissenschaftliche Berechnungen, Simulationen und andere datenintensive Workloads, z. B. in der Genomforschung. Mit der Cross-Node-High-Availability-Funktion sollen Dienste auch bei Ausfall eines Knotens unterbrechungsfrei bereitgestellt werden können. Array Migration ermöglicht den effizienten Umzug von RAID-Arrays zwischen Knoten, ohne dass eine Datenreplikation erforderlich ist. Der SupremeRAID HE wird in Zusammenarbeit mit Supermicro angeboten und ist für Umgebungen wie BeeGFS, Ceph und Lustre optimiert. Der Hersteller verspricht, Overhead zu reduzieren und die NVMe-Leistung optimal auszunutzen.

RAID-Architektur ohne Engpässe

Je nach eingesetztem Dateisystem oder Storage-System ist die Implementierung von RAID essentiell, um die erforderliche Ausfallsicherheit und Datenredundanz zu gewährleisten. Ein RAID-Controller ist das zentrale Element für die Verwaltung der physischen Festplatten innerhalb eines solchen RAID-Verbundes. Er übernimmt eine Vielzahl kritischer Aufgaben, darunter die Koordination der internen Kommunikation zwischen den Laufwerken, die Steuerung von Lese- und Schreibzugriffen sowie die Zusammenfassung der einzelnen Platten zu einer einzigen logischen Einheit, die oft als Volume oder Gruppe bezeichnet wird.

Im Gegensatz zu traditionellen Hardware-RAID-Controllern, deren Karten direkt im Datenpfad liegen und somit potenzielle Engpässe darstellen können, verfolgt Graid einen innovativen Ansatz. Seine Lösungen sind so konzipiert, dass die Controller-Karten nicht direkt im Datenpfad eingebunden sind. Diese Architektur ermöglicht es, das Grundsystem erheblich zu entlasten, da die SSDs sowie der RAID-Controller direkt am PCIe-Bus angeschlossen sind.

Das SupremeRAID-System geht noch einen Schritt weiter und verfügt über einen eigenen virtuellen NVMe-Controller, der auf Betriebssystemebene installiert wird. Diese Implementierung bewirkt, dass alle Berechnungen im Zusammenhang mit dem RAID auf das SupremeRAID-System ausgelagert und von der GPU übernommen werden. Diese fortschrittliche Technologie soll nahezu verlustfreie Übertragungsraten zu den im RAID-Verbund befindlichen SSDs ermöglichen und gleichzeitig die Gesamtleistung des Systems erheblich steigern.