DDN: Anwenderspezifische Speicher für erfolgreiche KI-Projekte

Der Hochleistungsspezialist DDN stellt mit »IndustrySync«, »XfusionAI« und »Infinia« modulare Speicherlösungen für anspruchsvolle KI- und HPC-Workflows bereit. Die Produkte sind auf niedrige Latenzen, hohe I/O-Leistung und branchenspezifische Anforderungen zugeschnitten – und sollen den Einsatz von KI in Unternehmen vereinfachen.

Der Hochleistungsspezialist DDN stellt mit »IndustrySync«, »XfusionAI« und »Infinia« modulare Speicherlösungen für anspruchsvolle KI- und HPC-Workflows bereit. Die Produkte sind auf niedrige Latenzen, hohe I/O-Leistung und branchenspezifische Anforderungen zugeschnitten – und sollen den Einsatz von KI in Unternehmen vereinfachen.

Künstliche Intelligenz (KI) erfordert viele neue technologische Ansätze. Unter anderem ist die Leistungsfähigkeit der zugrundeliegenden Technik erfolgskritisch für ein KI-Projekt. Lange Wartezeiten oder irrelevante Antworten sorgen schnell für Ablehnung bei Anwendern. In manchen Fällen kann das sogar lebensbedrohlich sein.

Für KI optimierte Infrastruktur (KI-Stack) umfasst software-definierte und Cloud-Dienste, KI-native Software und Services, fortschrittliche Managementfunktionen, leistungsoptimierte Rechenleistung und Netzwerktechnik sowie eine durchgängig hochgradig parallelisierte Datenverarbeitung. Anforderungen an KI-optimierte Speicher beinhalten die schnelle Bereitstellung von Daten für GPUs mit hohem Durchsatz (I/O) bei gleichzeitig geringer Latenz.

DDN verspricht die Beschleunigung von Training und Inferenz großer Sprachmodelle durch die Beschleunigung von Operationen wie Indizierung bzw. Suche oder Checkpointing sowie das schnellere Laden der Modelle sowohl On-Premise als auch in Multi-Cloud-Umgebungen. Dazu kombiniert der Hersteller Module wie EXAScaler und Infinia mit der Technologie von NVIDIA. Neu sind für bestimmte Anwendungsfälle optimierte One-Click-Lösungen, welche die Einführung und Anwendung von KI in Unternehmen erleichtern sollen. Der Spezialist für Hochleistungsspeicher stellte seine Industrielösungen im Rahmen der IT Press Tour vor.

Beschleunigung von KI- und HPC-Workflows

Vor allem das datenintensive KI-Training stellt die Infrastruktur vor Herausforderungen: Tokens und Modelle müssen für jeden Trainingszyklus geladen werden. Die Datenbewegung im Trainingsprozess kann einen Zeitanteil von bis zu 60 Prozent für Ingest/Data-Prep, bis zu fünf Prozent für Data-Load und bis zu 43 Prozent für Checkpointing oder Model-Load bzw. Distribution beanspruchen. Während dieser Zeit kann die GPU nichts machen außer Warten, verbraucht aber dennoch Strom und beansprucht Platz im Rechenzentrum. Die teure Ressource wird ineffizient.

Ein limitierender Faktor in Bezug auf Leistungsfähigkeit von KI-Infrastruktur sind herkömmliche Ethernet-basierte Netzwerke. Für KI-optimierte Netzwerke wird daher immer öfter die latenzarme Infiniband-Technologie genutzt.

DDN hat Exascaler für KI/ML-Workloads mit der Nvidia SuperPOD-Technologie weiterentwickelt und unterstützt Nvidia Spectrum-X mit BlueField-3 SuperNICs, um mit einer Lesegeschwindigkeit von bis zu 2,4 TByte/s die Ladezeiten von Checkpoints sowie Modellen und Daten zu beschleunigen.

Die DDN Exascaler-Plattform bietet vielfältige Funktionen, darunter Multi-Protokoll-Unterstützung für NFS, SMB und S3. Des Weiteren ermöglicht sie Online-Upgrades ohne Ausfallzeiten und verfügt über Mandantenfähigkeit mit der von Nvidia genehmigten NCP-Tenant-Verwaltung. Diese beinhaltet isolierte Datenpartitionen, dynamische Tenant-Netzwerke und -Quoten. Unterbrechungsfreie Online-Server-Updates inkl. System-Health-Checks und Konfigurationsprüfungen sind ab EXA 6.3.1 verfügbar. Neu ist auch die Option Docker-basierter Installationen. Die Sicherheit der Daten wird durch starke Authentifizierung, rollenbasierte Zugriffskontrollen, Verschlüsselung und Auditing gewährleistet. Zudem bietet DDN Exascaler die Überwachung laufender Workloads, Dateiverteilung oder Protokollnutzung, sowie Analysen zu historischen Workloads. Eine einfache Integration in Scheduling-Umgebungen ist ebenso möglich wie die Einbindung offener Tools wie Prometheus und Grafana. Zudem gibt es physische Ansichten der Hardware.

Infinia: Datenintelligenz für hybride Umgebungen

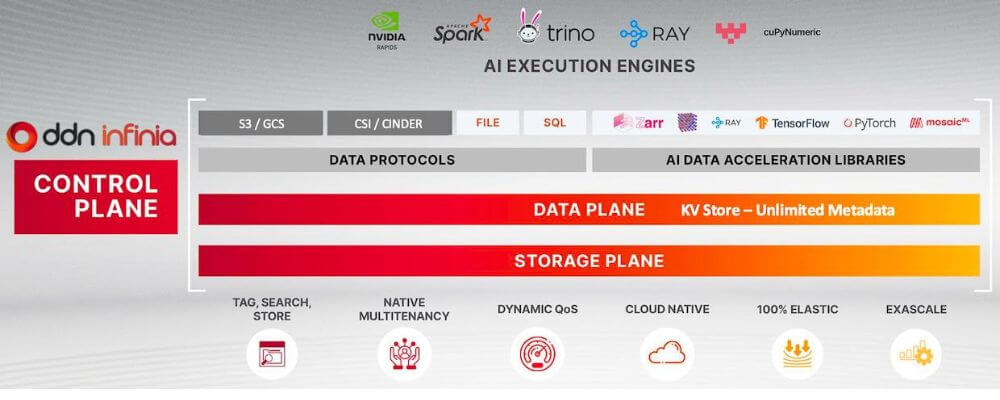

DDN Infinia ist eine software-definierte Data-Intelligence-Plattform, die für den Betrieb in verteilten Umgebungen konzipiert wurde. Plattformübergreifend können unstrukturierte, semistrukturierte und strukturierte Daten für eine Vielzahl moderner Workloads wie KI und Big-Data verarbeitet werden. Die Plattform besteht aus Steuerungsebene, Datenebene und Speicherebene.

DDN Infinia ist für Operationen mit kleinen Objekten in Cloud-Umgebungen optimiert. Die Bewältigung von Millionen gleichzeitiger Abfragen bei konstant niedriger Latenz ist entscheidend für die Entscheidungsfindung einer KI (Inferenz) in nahezu Echtzeit. Konsistenter, schneller Datenzugriff ist auch für RAG-Workflows (Retrieval Augmented Generation) kritisch. Leistungsstarke Workflows verbessern die Benutzererfahrung und steigern die Zufriedenheit.

DDN Fault Domains mit Erasure-Coding erlauben eine hohe Fehlertoleranz. Mandanten können die erforderliche Fehlertoleranz pro Dataset festlegen. Anwendungen sollen laut Hersteller selbst bei Ausfall eines ganzen Racks unterbrechungsfrei weiterlaufen können.

Hierarchische, granulare Rollen- und Berechtigungskonzepte können mit RBAC durchgesetzt werden. Sowohl LDAP als auch der Microsoft-Verzeichnisdienst Active Directory (AD) werden unterstützt. Für schnelle Zugriffe auf Daten mit niedriger Latenz werden Protokolle wie RDMA genutzt. Mit dem integrierten SDK-Connector können auch klassische Hadoop- oder Spark-Anwendungen wie MLlib für Maschinelles Lernen, GraphX für die Graphen-Verarbeitung oder das Streaming von Echtzeit-Datenströmen von dem schnelleren RDMA profitieren.

Die Plattform ist Hardware-agnostisch und multi-mandantenfähig. (Bild: DDN)

Die Plattform ist Hardware-agnostisch und multi-mandantenfähig. (Bild: DDN)

Industrysync: Industrielösungen mit einem Klick

DDN präsentierte IndustrySync, die den Einsatz von KI in Unternehmen vereinfachen soll. Die KI-One-Click-Lösung ist branchenspezifisch konzipiert: Finanzunternehmen profitieren von schnellerer Marktdatenverarbeitung, Biowissenschaften von beschleunigter Genomanalyse und autonomes Fahren von verbesserter Sensordatenverarbeitung.

Industrysync ist eine metadatengesteuerte KI-Daten-Engine, die als Orchestrator das Verschieben, Indizieren und Abrufen von Daten für die Hochgeschwindigkeits-KI-Verarbeitung automatisiert. Die Lösung kombiniert Exascaler für KI-Training, hohe Rechenleistung und schnelles Checkpointing mit Infinia zur KI-Datenverwaltung speziell für KI-Inferenz, Analyse und Modellvorbereitung für den nahtlosen Datenaustausch in hybriden Cloud-, Core- und Edge-Umgebungen. Die Lösung integriert mit HPC-Technologie und KI-Frameworks inklusive Nvidia NIM, Nemo, DGX, Spectrum-X, Bluefield-3, Nvidia Cloud Partners (NCP) und KI-Cloud-Anbietern wie AWS und GCP.

XfusionAI und Inferno: Speziallösungen für sensible Workflows

Industrysync ergänzt die ebenfalls erst 2025 vorgestellten Produkte XFusionAI und Inferno. Auch XfusionAI kombiniert das parallele Dateisystem Exascaler mit Infinia. Die hybrid konzipierte Plattform zielt darauf ab, KI-Workflows in bestimmten Anwendungsbereichen wie Arzneimittelentwicklung, Genomforschung und Präzisionsmedizin zu optimieren. Anwender berichten von 15-mal schnelleren KI-Workflows. XfusionAI kombiniert Exascaler mit Infinia und unterstützt On-Premises-, Cloud- und isolierte Systeme. Die Lösung unterstützt extra-große Sprachmodelle mit bis zu einer Billion Parameter.

Inferno kombiniert Infinia mit NVIDIA DGX-Systemen und Cloud-Partnern (NCPs), um die metadatengesteuerte Indizierung und Suche in Echtzeit zu ermöglichen. Autonomes Fahren und Hochfrequenzhandel sind zwei Anwendungsfälle, in denen die Latenz kritisch für den Erfolg einer KI-Lösung ist. Im medizinischen Sektor kann Latenz bei der Diagnostik und Patientenüberwachung sogar lebensbedrohlich sein. Weitere Bereiche, die von Rückschlüssen und Entscheidungsgrundlagen in Echtzeit profitieren, sind Betrugserkennung und Risikomodellierung in dynamischen Umgebungen.

DDN: Technologische Wurzeln und strategische Zukäufe

DDN profitiert von einer Vielzahl von Zukäufen der letzten Jahre. Für Exascaler kombinierte DDN, die man bis 2020 noch als DataDirect Networks kannte, das Nexenta-Dateisystem mit Tintri – einem Speicher für virtuelle Maschinen (VM) – und der Speicherverwaltung von IntelliFlash. Tegile Systems, das Unternehmen hinter der ursprünglich als Zebi bekannten IntelliFlash Metadata Acceleration, wurde 2017 von Western Digital gekauft. 2019 übernahm DDN die Technologie. Ein Jahr später kaufte DDN den insolventen Marktbegleiter Tintri. Nexenta, die lange Zeit den Markt für ZFS-Speicher dominierten, wurden ebenfalls 2019 von DDN übernommen.

Nexenta nutzte sehr früh RSF-1, eine auf Unix basierte und für kommerzielle Anwendungen entwickelte High-Availability-Cluster-Software, mit der Anwendungen und Dienste auch im Falle von HW-Ausfällen zuverlässig weiterlaufen können. Ebenfalls 2018 übernahm DDN die Reste der als Cluster File Systems gestarteten Firma hinter dem parallelen HPC-Dateisystem Lustre. Nicht von ungefähr steht unter dem Managed Lustre der Google Cloud-Plattform der Name DDN. Wie alle parallelen Filesysteme stellt auch Lustre die Daten allen Clients in einem einheitlichen Namensraum zur Verfügung. Seine Beliebtheit dürfte es der Verwendung der Standard-POSIX-Semantik verdanken. Der Brand selbst war übrigens nicht Teil der Verhandlungsmasse und gehört heute der Community.

Im Gegensatz zu vielen anderen Firmen, die ihre Technologie lieber kaufen als selbst entwickeln, gelingt DDN die Integration in die eigenen Produkte gut. Am besten ist das an der Leistungsfähigkeit der Plattform zu erkennen. DDN verweist alle anderen Anbieter im MLPerf Storage Benchmark regelmäßig auf die Plätze. Mit der Benchmark-Suite lässt sich vergleichen, wie schnell Speichersysteme Trainingsdaten für das Training von KI-Modellen liefern können.