Interview: Parallel-Processing-Software wird zum »Game Changer«

Parallel-I/O-Technologien haben das Potenzial, die Datacenter zu verändern. Herkömmliche Applikations- und Storage-Bereiche für Geschäftstransaktionen, Cloud-Computing, Datenbanken, Datenanalyse, interaktive Anwendungen und das IoT sollen davon profitieren. Davon gibt sich George Teixeira, President und CEO von Datacore Software, im Interview überzeugt.

Herr Teixeira, welche Technologie sehen Sie als den entscheidenden Impulsgeber für das laufende Jahr?

George Teixeira, President und CEO, Datacore SoftwareTeixeira: Ich bin überzeugt davon, dass Parallel-Processing-Software in der Tat ein »Game Changer«, ein entscheidender Impulsgeber im Jahr 2017 werden wird, vor allem, weil sie umwälzende Auswirkungen auf die Produktivität in Rechenzentren hat. Trotz aller technologischen Fortschritte bleibt immer noch so viel Computing-Potenzial moderner Multi-Core-Systeme ungenutzt, statt damit die Wirtschaftlichkeit, Produktivität und Einsatzgebiete der IT maßgeblich zu steigern. Parallel-Processing wird aus spezifischen Anwendungsfeldern wie HPC oder Molekularbiologie heraustreten und ein breiteres Spektrum an Applikationen erreichen. Herkömmliche Applikations- und Storage-Bereiche für Geschäftstransaktionen, Cloud-Computing, Datenbanken, Datenanalyse, interaktive Anwendungen und das IoT werden profitieren.

George Teixeira, President und CEO, Datacore SoftwareTeixeira: Ich bin überzeugt davon, dass Parallel-Processing-Software in der Tat ein »Game Changer«, ein entscheidender Impulsgeber im Jahr 2017 werden wird, vor allem, weil sie umwälzende Auswirkungen auf die Produktivität in Rechenzentren hat. Trotz aller technologischen Fortschritte bleibt immer noch so viel Computing-Potenzial moderner Multi-Core-Systeme ungenutzt, statt damit die Wirtschaftlichkeit, Produktivität und Einsatzgebiete der IT maßgeblich zu steigern. Parallel-Processing wird aus spezifischen Anwendungsfeldern wie HPC oder Molekularbiologie heraustreten und ein breiteres Spektrum an Applikationen erreichen. Herkömmliche Applikations- und Storage-Bereiche für Geschäftstransaktionen, Cloud-Computing, Datenbanken, Datenanalyse, interaktive Anwendungen und das IoT werden profitieren.

Und was werden die Treiber bei den Anwendern für den Einsatz von Parallel-Processing-Software sein?

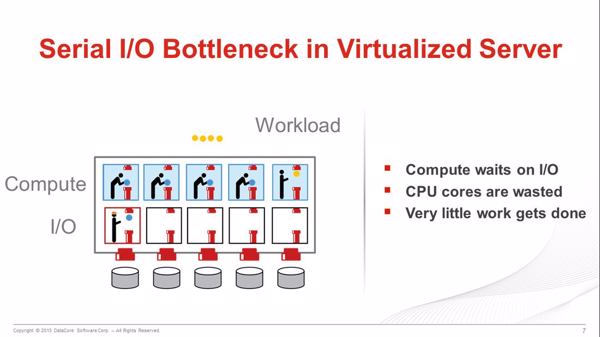

Bei Serial-I/O muss die parallel arbeitende CPU ständig auf die I/O-Prozesse warten (Bild: Datacore Software)Teixeira: Zunächst: Diese Software lässt sich einfach anwenden und nahtlos in die allgemeine Nutzung einbinden. Wenn sie dies tut, kann sie die Antwortzeiten von Applikationen, Workloads und Systemdichte in virtualisierten Umgebungen und der Cloud extrem verbessern, da diese nicht mehr unter dem Missverhältnis zwischen Compute- und I/O-Leistung leiden. Treiber dieser Entwicklung sind der zunehmende Mangel an Wirtschaftlichkeit und Produktivität. Heute sind neue Applikationen beispielsweise im Bereich der Analytics nicht praktikabel, weil sie hunderte, wenn nicht tausende Server verschlingen, die Multi-Threading beherrschen, aber den I/O-Job nicht erledigen können. 2017 werden wir Innovationen sehen, die dafür sorgen, dass ein Server so viel leistet wie zehn oder 100 Server in der Vergangenheit. Dies wird durch neue Parallel-I/O-Technologien möglich, die keine Veränderungen an Applikationen erfordern, jedoch die volle Leistungskraft der Multi-Core-Architekturen nutzen kann, um den I/O-Flaschenhals zu beseitigen. Dies führt zu einer 2017 revolutionär besseren Produktivität in der Mainstream-IT.

Bei Serial-I/O muss die parallel arbeitende CPU ständig auf die I/O-Prozesse warten (Bild: Datacore Software)Teixeira: Zunächst: Diese Software lässt sich einfach anwenden und nahtlos in die allgemeine Nutzung einbinden. Wenn sie dies tut, kann sie die Antwortzeiten von Applikationen, Workloads und Systemdichte in virtualisierten Umgebungen und der Cloud extrem verbessern, da diese nicht mehr unter dem Missverhältnis zwischen Compute- und I/O-Leistung leiden. Treiber dieser Entwicklung sind der zunehmende Mangel an Wirtschaftlichkeit und Produktivität. Heute sind neue Applikationen beispielsweise im Bereich der Analytics nicht praktikabel, weil sie hunderte, wenn nicht tausende Server verschlingen, die Multi-Threading beherrschen, aber den I/O-Job nicht erledigen können. 2017 werden wir Innovationen sehen, die dafür sorgen, dass ein Server so viel leistet wie zehn oder 100 Server in der Vergangenheit. Dies wird durch neue Parallel-I/O-Technologien möglich, die keine Veränderungen an Applikationen erfordern, jedoch die volle Leistungskraft der Multi-Core-Architekturen nutzen kann, um den I/O-Flaschenhals zu beseitigen. Dies führt zu einer 2017 revolutionär besseren Produktivität in der Mainstream-IT.

Können Sie den Einfluss auf Anwendungen wie Echtzeit-Analytik und Big Data erläutern?

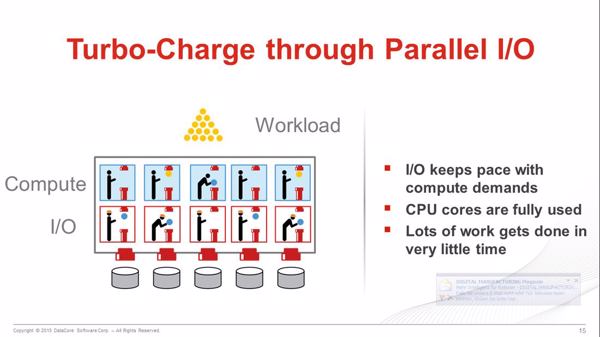

Parallel-I/O löst den Flaschenhals für die parallel arbeitende CPU, die nun nicht mehr auf die I/O-Prozesse warten muss (Bild: Datacore Software)Teixeira: Der Schlüssel ist die parallele I/O-Abarbeitung, da diese Applikationen immer mehr Interaktionen und Transaktionen mit immer höherer Geschwindigkeit in kürzeren Latenzzeiten erfordern. Die Kombination kürzerer Latenz mit größerer Produktivität durch Parallelisierung wird Echtzeit-Analysen, Big Data und Datenbankperformance weiter voranbringen, da sie diese Anwendungen praktikabel und bezahlbar macht. Die Auswirkungen auf die Produktivität und die unternehmerische Entscheidungsfindung auf der Grundlage von Daten-Erkenntnissen in Sektoren wie Finanz- und Bankenwesen, Einzelhandel, Betrugserkennung, Gesundheitswesen und Mikrobiologie sowie im Bereich maschinellen Lernens (Machine Learning) und der so oft beschworenen Internet-of-Things-Anwendungen werden tiefgreifend sein.

Parallel-I/O löst den Flaschenhals für die parallel arbeitende CPU, die nun nicht mehr auf die I/O-Prozesse warten muss (Bild: Datacore Software)Teixeira: Der Schlüssel ist die parallele I/O-Abarbeitung, da diese Applikationen immer mehr Interaktionen und Transaktionen mit immer höherer Geschwindigkeit in kürzeren Latenzzeiten erfordern. Die Kombination kürzerer Latenz mit größerer Produktivität durch Parallelisierung wird Echtzeit-Analysen, Big Data und Datenbankperformance weiter voranbringen, da sie diese Anwendungen praktikabel und bezahlbar macht. Die Auswirkungen auf die Produktivität und die unternehmerische Entscheidungsfindung auf der Grundlage von Daten-Erkenntnissen in Sektoren wie Finanz- und Bankenwesen, Einzelhandel, Betrugserkennung, Gesundheitswesen und Mikrobiologie sowie im Bereich maschinellen Lernens (Machine Learning) und der so oft beschworenen Internet-of-Things-Anwendungen werden tiefgreifend sein.

Wie werden sich die Parallel-I/O-Technologie auf Microsoft-Technologien wie Azure-Stack, Hybrid-Cloud, Windows und SQL Server 2016 auswirken?

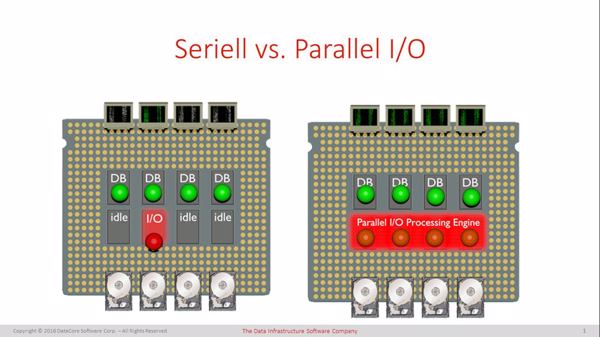

Vor allem Datenbanken profitieren enorm von Parallel-I/O-Technologie (Bild: Datacore Software)Teixeira: Microsoft hat als einer der ersten Anbieter verstanden, dass auch zukünftig On-Premise- und Cloud-Architekturen nebeneinander existieren. Erfolg und Wachstum von Microsofts Azure-Cloud sind bereits offensichtlich, aber so richtig kommt das erst durch Microsofts Strategie zu tragen, beide Welten zu kombinieren. So wird der Microsoft-Azure-Stack weiterentwickelt, um eine nahtlose Verbindung zwischen Public- und Private-Cloud herzustellen. Er ist das Vorbild für die Hybrid-Cloud geworden. Ebenso setzt Microsoft die Integration seiner Windows- und Server-Lösungen weiter fort, um noch besser und übergangslos in der Cloud arbeiten zu können.

Vor allem Datenbanken profitieren enorm von Parallel-I/O-Technologie (Bild: Datacore Software)Teixeira: Microsoft hat als einer der ersten Anbieter verstanden, dass auch zukünftig On-Premise- und Cloud-Architekturen nebeneinander existieren. Erfolg und Wachstum von Microsofts Azure-Cloud sind bereits offensichtlich, aber so richtig kommt das erst durch Microsofts Strategie zu tragen, beide Welten zu kombinieren. So wird der Microsoft-Azure-Stack weiterentwickelt, um eine nahtlose Verbindung zwischen Public- und Private-Cloud herzustellen. Er ist das Vorbild für die Hybrid-Cloud geworden. Ebenso setzt Microsoft die Integration seiner Windows- und Server-Lösungen weiter fort, um noch besser und übergangslos in der Cloud arbeiten zu können.

Eine der wichtigsten Neuerungen bei Microsoft ist, dass sie ihre Datenbank als echte Big-Data- und Analytics-Plattform für die Zukunft weiterentwickelt haben. SQL Server 2016 ist deutlich leistungsfähiger und bewältigt nun alle Arten von Daten. Als Plattform ist es darauf ausgerichtet, mit Microsofts breitem Netz von Kooperationspartnern und deren Diensten zu funktionieren. Datacore mit seinen Parallel-Processing-Innovationen ist ein Teil dieses Partnernetzwerks und hilft dabei, die Möglichkeiten für Rechenzentren neu aufzustellen: Was ist in Unternehmen mit der Cloud und der Big-Data-Performance machbar? Welche Echtzeit-Analytics lassen sich so gestalten, dass sie für herkömmliche Geschäftsanwendungen ebenso wie für neue Anwendungsbereiche wie dem Maschinellen Lernen, dem Cognitive-Computing und im Internet der Dinge (IoT) anwendbar sind?

Wie hat sich Ihrer Meinung nach Storage in den letzten Jahren verändert?

Teixeira: Server bestimmen zunehmend, was Storage ist. Storage besteht heute vielmehr aus Server und Software-definierter Infrastruktur. Traditionelle Speichersysteme können dabei nicht mehr mithalten und werden durch Standard-Server ersetzt, die Software nutzen, um die Storage-Herausforderungen zu bewältigen. Storage-Services werden dabei zu einer Applikation und damit flexibel und kosteneffizineter. Server-SAN, virtuelles SAN, webskalierte, scale-out und hyper-konvergente Systeme sind allesamt zusammengesetzt aus Standard-Hardware, -Flash und -Disks, den wahren Unterschied macht die Software. Parallel-Processing-Software für die optimale Nutzung von Multicore-Servers wird dabei zu einer revolutionär höheren Produktivität führen und das Credo »Server ist das neue Storage« weiter etablieren. Studien, wie Parallel-I/O-Software mit Standardhardware zum weltweiten Spitzenreiter in Sachen Performance, Preis-Performance und Latenz wird, liegen bereits vor.

Was kommt nach Flash?

Teixeira: Flash war die nächste große Sache – und hat sich längst etabliert. Aber nach wie vor sind Produktivität und Performance ein Problem für viele Enterprise-Applikationen, vor allem Datenbanken. Die Antwort ist also: Wir benötigen die Parallelisierung des I/O-Processing. Dadurch, dass wir die Technologie so nahe wie möglich an die Applikation heranführen, vermeiden wir überflüssigen I/O-Traffic zwischen Geräten und bewirken dabei weitaus mehr als nur die Optimierung einzelner Geräte, wie es durch Flash und SSD der Fall ist. Mit der Kombination von Flash und Parallel-I/O können wir mehr Anwendungen schneller nutzen, mehr Arbeit erledigen und gleichzeitig neue Anwendungsfelder öffnen.

Hyper-Konvergenz ist so ein Thema, und es ist ein weiterer Wachstumsmarkt. Hyperkonvergente Systeme bestehen heute im Wesentlichen aus einem Server und einer software-definierten Infrastruktur, aber oft sind sie in Bezug auf Performance- und Anwendungsfälle stark eingeschränkt und zu oft fehlen ihnen die Flexibilität und die Möglichkeiten, um in die gesamte IT-Umgebung implementiert zu werden (zum Beispiel, weil sie Fibre-Channel nicht unterstützen, ein häufiges Schlüsselelement für Unternehmens- und Datenbank-Konnektivität). Hyper-konvergente Software wird immer populärer werden, aber um ihren Erfolg zu sichern, müssen die Nutzer in der Lage sein, das ultimative Produktivitätsversprechen hyperkonvergenter Systeme voll auszuschöpfen. Das eigentliche Ziel ist eine Art Hyperproduktivität zu so geringen Kosten wie möglich und der bestmöglichen Leistungsstärke. Eine bessere Auslastung der eigenen Speicher und Server, um Anwendungen reibungsfrei zum Laufen zu bringen, ist entscheidend.

Dieses Video von ESG zeigt: Mit der Parallel-Processing-Software können Anwender die Vorteile von Hardware und Software nutzen.

So kann die Software alle vorhandenen Flash- und Plattenspeicher integrieren, ohne dass zusätzliche Silos entstehen; die Daten-Migration und -Verwaltung über die gesamte Speicherinfrastruktur wird möglich, und der Anwender kann in der Cloud gespeicherte Daten effektiv nutzen. Gleichzeitig lassen sich Kosten sparen, weil etwa weniger Nodes benötigt werden, wenn leistungsstarke Software-definierte Speichertechnologien parallel mehrere I/O-Funktionen ausüben können. So profitieren auch hyperkonvergente Systeme von der Parallel-I/O-Technologie.

Und was sehen Sie schlussendlich als den nächsten großen Wurf für 2017?

Teixeira: Der nächste Schritt besteht aus Parallel-Processing und seinen Auswirkungen auf die Produktivität. Weiterhin werden software-definierte Lösungen die kostengünstige Nutzung von Standardhardware vorantreiben. Software sorgt für größere Funktionalität, mehr Automation und umfassende Services in der kompletten Dateninfrastruktur. Parallel-Processing-Software wird dabei die ungenutzten Computing-Kapazitäten zugänglich machen, niedrige I/O-Raten und unzumutbare Latenzen eliminieren, die der Performance von Applikationen ebenso im Weg stehen wie tatsächlichen Kosteneinsparungen durch Konsolidierung. All dies zusammen wird neue Applikationen und Anwendungsfelder mit höherer Leistung, Echtzeit-Reaktionsfähigkeit, eine massive Konsolidierung und kleinere Footprints ermöglichen.

- George Teixeira ist President und CEO von Datacore Software und einer der Mitbegründer des Unternehmens im Jahre 1998. Zuvor war Teixeira in einer Reihe von Führungspositionen tätig, unter anderem als Worldwide VP of Marketing und Geschäftsführer der Product Business Group bei Encore Computer Corporation, wo er auch eine wichtige Rolle als Teamleiter für das OEM-Marketing und Vertriebsgeschäft mit Amdahl, IBM und DEC spielte. Im Jahr 1997 krönte er seine Arbeit mit dem Verkauf der Speichersteuerungssparte von Encore an Sun Microsystems für 185 Millionen US-Dollar. Teixeira bekleidete außerdem mehrere leitende Managementpositionen in der Computer Systems Division von Gould Electronics. George Teixeira wurde auf Madeira (Portugal) geboren. Er hat den MBA an der Florida Atlantic University erworben, und hält darüber hinaus Bachelor-Abschlüsse in Biologie und Chemie.

- Datacore Software

- Datacore-Microsite bei speicherguide.de

- Distributor Macle schnürt Komplettlösungen mit Datacore

- Für Vmware-Profis gibts kostenlose Datacore-Virtual-SAN-Lizenzen

- Datacore räumt mit Mythen rund um Hyperkonvergenz auf

- Datacore-Kunden bestätigen deutlich weniger Storage-Downtime

- Kommender »DataCore Parallel Server« überzeugt erneut im Benchmark