Dell-Ausblick 2026: KI verlässt Experimentierstadium

John Roese, CTO und Chief AI Officer von Dell Technologies, skizziert Trends für 2026: Governance als Engpass, eine neue Knowledge-Layer zwischen Daten und AI-Compute, autonome Agenten als Organisationsfaktor sowie »Sovereign«-Anforderungen. Zusätzlich rückt Resilienz für AI-Factories in den Fokus, inklusive Backup, Survivability und Cyber-Recovery.

John Roese, CTO und Chief AI Officer von Dell Technologies, skizziert Trends für 2026: Governance als Engpass, eine neue Knowledge-Layer zwischen Daten und AI-Compute, autonome Agenten als Organisationsfaktor sowie »Sovereign«-Anforderungen. Zusätzlich rückt Resilienz für AI-Factories in den Fokus, inklusive Backup, Survivability und Cyber-Recovery.

2026 markiert den Übergang von Experimenten und Pilotprojekten hin zu produktiven, geschäftskritischen AI-Workloads. In dieser Phase rückt nicht mehr das »Ob«, sondern das »Wie« in den Vordergrund: Unternehmen müssen AI-Workloads operativ beherrschbar machen, sie in Prozesse und Datenstrukturen einbetten und gleichzeitig Governance, Kostenkontrolle und Sicherheit so aufstellen, dass Skalierung überhaupt möglich wird.

John Roese, DellCTO und Chief AI Officer bei Dell Technologies, setzt hierfür zwei Leitplanken: Hybrid-AI gelte künftig als Normalfall, und AI entwickle sich als verteiltes System in Unternehmen und Umgebungen weiter auseinander, statt zentraler zu werden. Daraus soll eine neue Infrastruktur-Realität entstehen, rund um AI-Factories, Knowledge-Layer und Agenten, die den Wert der AI-Anwendungen trägt und entsprechend, wie ein kritischer Produktionsbereich behandelt werden muss – inklusive klarer Anforderungen an Verfügbarkeit und Wiederanlauf im Störfall.

John Roese, DellCTO und Chief AI Officer bei Dell Technologies, setzt hierfür zwei Leitplanken: Hybrid-AI gelte künftig als Normalfall, und AI entwickle sich als verteiltes System in Unternehmen und Umgebungen weiter auseinander, statt zentraler zu werden. Daraus soll eine neue Infrastruktur-Realität entstehen, rund um AI-Factories, Knowledge-Layer und Agenten, die den Wert der AI-Anwendungen trägt und entsprechend, wie ein kritischer Produktionsbereich behandelt werden muss – inklusive klarer Anforderungen an Verfügbarkeit und Wiederanlauf im Störfall.

Künstliche Intelligenz erfordert Governance

Roese stellt Governance an die Spitze seiner Liste und trennt externe von interner Governance. Extern beschreibt er eine zersplitterte Lage mit »über tausend« Jurisdiktionen, die eigene AI-Regeln geschaffen hätten, ohne Koordination. Für Unternehmen werde damit schwer kalkulierbar, wie regulierte Use Cases sauber in Produktion gehen können. Das führe dazu, dass genau diese Fälle eher gemieden werden. Sein Appell lautet daher Harmonisierung, weil sonst ein spürbarer Bremsfaktor für die AI-Produktivsetzung entstehe.

Intern meint Governance weniger Bürokratie als Priorisierung. Ohne klare Regeln und die Fähigkeit, Vorhaben zu stoppen, würden Unternehmen nicht wenige Projekte konsequent umsetzen, sondern sehr viele parallel starten. Das streue knappe Expertenressourcen und verhindere den Sprung in den Regelbetrieb.

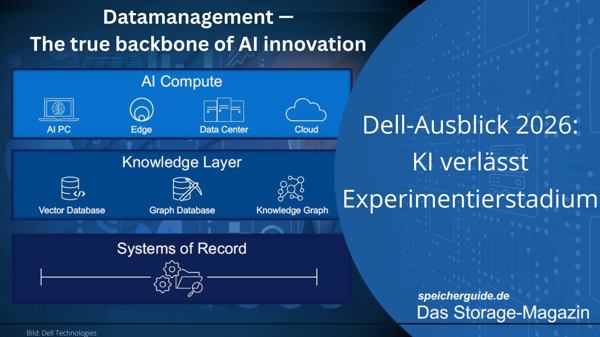

AI-Infrastruktur als Stack

Bei der Infrastruktur sieht Roese AI-Compute nach 2024 und 2025 als weitgehend verstanden. Den Engpass verortet er in der Schicht zwischen Systems-of-Record wie CRM und ERP und den AI-Workloads. Diese Knowledge-Layer bündele Vektor-Datenbanken, Graph-Datenbanken und Knowledge-Graphs, die AI-Systeme effizient mit Unternehmenswissen versorgen.

Wichtig ist dabei die Positionierung. Statt solche Strukturen ad hoc an bestehende Systeme anzuflanschen, soll die Knowledge-Layer als eigenständige Ebene geplant werden, näher an der Compute-Seite als an klassischen, nicht echtzeitfähigen Systems-of-Record. Roese betont außerdem, dass diese Schicht high-performant und extrem resilient sein müsse. Storage sei dort praktisch nur warm oder heiß. Als Trend nennt er Integrationsansätze zwischen Compute und Knowledge-Layer, etwa von NVIDIA.

Agenten sorgen für Veränderungen

Autonome Agenten grenzt Roese von »Agent-Washing« ab. Gemeint seien nicht beliebige Chatbots, sondern Systeme aus LLM, spezialisiertem Wissen, Gedächtnis, Tool-Nutzung sowie Agent-to-Agent-Kommunikation. Seine zentrale Aussage ist organisatorisch. Agenten wirkten nicht nur als neue Tools, sondern als digitale Worker, die Abläufe, Rollen und Teamarbeit verändern können.

Gleichzeitig warnt er vor »agentic economics«. Preismodelle für Agent-as-a-Service seien oft unreif und könnten bei transaktionsbasierter Abrechnung schnell Budgetrisiken erzeugen. Als Gegenmaßnahme nennt er Kontrolle über Betrieb und Identitäten. Agenten sollten eine ausstell- und entziehbare Unternehmensidentität tragen, vergleichbar mit einem Badge.

Resilienz für AI-Factories: Backup, Survivability und Cyber-Recovery

Vierte Prognose ist Resilienz für AI-Factories, also Backup, Survivability und Cyber-Recovery. Dies sei der »nächste logischen Schritt« nach dem Aufbau der ersten AI-Factories ein. Sobald diese Umgebungen nicht nur Demo-Workloads, sondern »real work« tragen, entsteht zwangsläufig die Erwartung, dass die Systeme »in every scenario« weiterlaufen. »Genau hier ist eine Lücke«, mahnt Roese. »Für Cyber-Resilienz und System-Resilienz in AI-Factories gibt es branchenweit noch keinen guten, geschweige denn konsistenten Ansatz.«

Als kurzfristige Notlösung nennt Roese das Duplizieren kompletter AI-Factories. Das funktioniere zwar, sei aber ineffizient. Für 2026 erwartet er deshalb intensive Entwicklungsarbeit und neue Architekturen, die sich von klassischen Rechenzentrums-Workloads unterscheiden. Als Muster beschreibt er virtuelle AI-Factories, also logische Recovery-Repräsentationen, die in GPU-starker Infrastruktur liegen, aber erst bei Bedarf aktiviert werden. Zusätzlich könnten autonome Agents Failover- und Resilienz-Funktionen übernehmen, auch weil CSPs und souveräne Umgebungen neue Optionen für Recovery-Standorte eröffnen.

Dabei erweitert sich auch das Schutzgut. Neben Daten rücken Knowledge-Graphs, Vektor-Datenbank-Strukturen und Agents selbst in den Fokus. Klassische Werkzeuge wie Cyber-Vaults, Cyber-Recovery und Data Protection müssten sich dafür weiterentwickeln. Zudem rechnet Roese mit regulatorischer Kontrolle und souveränen Vorgaben, die Transparenz über Recovery-Fähigkeiten verlangen. Bei kritischen Infrastrukturen könne das bedeuten, dass Backup- und Recovery-Kapazitäten innerhalb derselben Souveränität liegen müssen.

Souveränität als Betriebsmodell: Robotik, autorisierte Agenten und Recovery im Rechtsraum

Unter dem Schlagwort »Sovereign« spannt Roese einen Bogen, der weit über die übliche Diskussion zu Government-Services oder dem Training großer Modelle hinausgeht. Für ihn wird Souveränität zum Betriebsprinzip für AI, weil neue Anwendungsfälle nur dann tragfähig sind, wenn Kontrolle über Standort, Betrieb und Regeln gesichert ist. »Unsere fünfte Prognose befasst sich mit Souveränität«, erklärt Roese. »Das ist heute weit darüber hinaus wertvoll.« Diese Logik zieht sich durch seine Beispiele, angefangen bei Physical-AI und Robotik. Entscheidend sei nicht nur der Roboter als nationales Asset, sondern auch die dahinterliegende »World-Brain«-Infrastruktur: »Man kann sich kaum vorstellen, dass man nicht kontrolliert, wo dieses World Brain tatsächlich läuft.«

Dazu kommen Agenten in Rollen, die formale Autorisierung voraussetzen, etwa in Steuer-, Rechts- oder Healthcare-Domänen. Wenn Agenten solche Funktionen übernehmen, werden Zertifizierung, Zuständigkeit und Speicherort des Langzeitwissens zur operativen Voraussetzung. Souveränität verknüpft Roese außerdem mit Resilienz, wenn AI-Factories kritische Infrastruktur wie Stromnetze stützen. Recovery wird dann zur Frage des Rechtsraums. Ergänzend erwartet er mehr Relevanz beim Training und Fine-Tuning kleinerer, spezialisierter Modelle, wofür souveräne AI-Factories auch kleineren Organisationen Compute-Zugang verschaffen könnten. Für grenzüberschreitende Zusammenarbeit skizziert er »Interworking-Zones« als kontrollierte Kollaborationsräume. Kernmotiv ist Vertrauen.

Quantum im Blick: Algorithmik, Fehlerkorrektur und der AI-Beschleuniger

Quantum-Computing gilt 2026 nicht als Jahr des großen Durchbruchs, aber als Phase mit spürbarem Fortschritt bei der Annäherung von Algorithmus-Anforderungen und verfügbarer Hardware. »Die Lücke zwischen dem Qubit-Bedarf für nützliche Arbeit – Quantum Utility bzw. Supremacy – und der Leistungsfähigkeit realer Systeme schließt sich schnell«, meint Dell-Manager Roese. Beispiele sind unter anderem Quantinuum mit einem »90-irgendwas«-Qubit-System mit vollständiger Fehlerkorrektur sowie IBM System 2 mit 120 Qubits.

Gleichzeitig komme Bewegung von der Software-Seite: Innovationen reduzierten teils drastisch die Qubit-Zahl, die bestimmte fortgeschrittene Algorithmen benötigen, etwa bei Optimierungsproblemen. Trotz dieser Fortschritte klafft noch eine Lücke, weil die größten Systeme zwar bei gut 100 fehlerkorrigierten Qubits liegen, während besonders interessante Algorithmen weiterhin mehrere Hundert Qubits erfordern.

»Gegenüber dem Vorjahr ist das ein großer Sprung, und AI wirkt als Beschleuniger, weil sie sowohl bei der Entwicklung von Algorithmen als auch beim Management der Systeme eingesetzt werden«, argumentiert Roese. »Für 2026 heißt das: viel Aktivität im Quantum-Umfeld, erste Beispiele für Utility rücken näher, aber die Welt wird im nächsten Jahr weiterhin vor allem von AI geprägt.«