Interview mit Fujitsu: Archivierungsstrategie entlastet Backup

Virtualisierung, Cloud, Software-defined Storage und Datenexplosion verändern die Rechenzentren. Hinzu kommt, dass der Großteil der Daten neuerdings unstrukturiert vorliegen wird – und somit nicht verwertbar ist. Zeitrahmen und Budget für Datensicherung und Backup laufen völlig aus dem Ruder. Wie die Zeitfenster für Backup-Prozesse weiter zu verkürzen und festgelegte Recovery-Ziele bestmöglich einzuhalten sind, darüber sprach speicherguide.de mit Stefan Roth, Manager Center of Excellence Storage & Network Solutions Technology Integration Services bei Fujitsu.

Sind angesichts des rasanten Datenwachstums die bekannten Backup-Strategien vergangener Tage passe? Oder genügt es, bekannte Backup-Strategien lediglich anzupassen?

Stefan Roth, Manager Center of Excellence Storage & Network Solutions Technology Integration Services, FujitsuRoth: Viele Unternehmen sind heute schon angehalten, ihre Backup-Strategien und damit auch ihre Infrastrukturen zu überdenken, da Technologien gemäß ihrer Effizienz für den richtigen Bedarf eingesetzt werden müssen.

Stefan Roth, Manager Center of Excellence Storage & Network Solutions Technology Integration Services, FujitsuRoth: Viele Unternehmen sind heute schon angehalten, ihre Backup-Strategien und damit auch ihre Infrastrukturen zu überdenken, da Technologien gemäß ihrer Effizienz für den richtigen Bedarf eingesetzt werden müssen.

Deduplizierung galt in der Vergangenheit als das Allheilmittel schlechthin, wurde dem aber in der Praxis in vielen Fällen nicht wirklich gerecht. Denn viele Daten – dazu zählen etwa Video-, Sensor- und Steuerungsdaten – lassen sich nicht hinreichend deduplizieren. Ebenso sind Datenschutzanforderungen nur schwer abbildbar.

Aber gäbe es da nicht auch noch Snapshots?

Roth: Snapshots alleine sind ebenfalls nicht ausreichend, da keine Klassifizierung der Daten vorgenommen wird und der Restore aufwändig ist, insbesondere beim Auffinden gewünschter Dateien. Ähnlich verhält es sich mit weiteren klassischen Technologien. So geht es bei Data-Protection im Wesentlichen um den Restore und darum, wie schnell der Nutzer wieder auf die gewünschten Daten zugreifen kann. Zum Vergleich: Die Daten-Wiederherstellung bei Deduplizierung dauert oft zehn Mal so lange wie bei einem klassischen Backup.

Zukünftig wird es entscheidend sein, verschiedene Technologien je nach Anforderungen an die jeweiligen Datentypen einzusetzen und diese auch effizient zu mischen. Der Einsatz verschiedener Technologien, Medien und Architekturen bedeutet meist ebenso mehr Aufwand, auch um die Daten zu klassifizieren, die nötigen SLAs zu definieren und die Daten auf der richtigen Online-Storage-Architektur abzulegen. Existenziell ist, wie so oft, eine gute Planung und dass sich die unterschiedlichen Technologien einfach miteinander kombinieren lassen. Ein möglichst übergreifendes Management ist ebenfalls von größter Bedeutung, denn die »Wichtigkeit« der Daten verändert sich über die Zeit hinweg.

Müssen evtl. vollkommen neue Backup-Strategien, -Philosophien, -Strukturen oder gar -Architekturen entwickelt werden?

Roth: So manch vorhandene Technologie kann einfach integriert und dem jeweils sinnvollen Verwendungszweck zugeführt werden – trotzdem ist es wichtig, die übergreifenden Strategien und Strukturen anzupassen. Wie schon erwähnt, ist der effiziente und passende Einsatz der Technologien anhand deren Effizienz und Daten-Verfügbarkeit von höchster Priorität. Auch gibt es neue Architekturen für das Backup schon in Applikationen. So bietet beispielsweise die Datenbank Oracle ZDLRA spezielle Sicherungs- und Wiederherstellungs-Möglichkeiten.

Woran sollten Administratoren in den Unternehmen arbeitet, um ihr Backup für den weiterhin tobenden Daten-Tsunami fit zu halten?

Roth: Administratoren in Unternehmen sollten die Daten-Wachstumsraten in jedem Fall deutlich höher kalkulieren als zum jetzigen Zeitpunkt üblich. Um die eigene Infrastruktur möglichst an den Anforderungen der Zukunft ausrichten zu können, muss diese flexibel sein.

Außerdem wichtig sind folgende Punkte:

► Klassifizierung der Daten

► Ausrichtung an Recovery-Anforderungen

► Nutzung der richtigen Technologien im Online-Storage (Snapshots dort einbeziehen, wo es sinnvoll ist, aber inklusive Indizierung und Möglichkeit des weiteren Backups/der Archivierung. Object Storage in bestimmten Bereichen nutzen, um Daten gar nicht erst sichern zu müssen, da sie schon abgesichert sind)

► Einführung und konsequente Umsetzung einer Archivierungsstrategie. Dies reduziert die Datenmenge auf den Primär-Speichern, den Backup-Speichern, reduziert die Backup-Zeiten und vor allem auch Wiederherstellungszeiten.

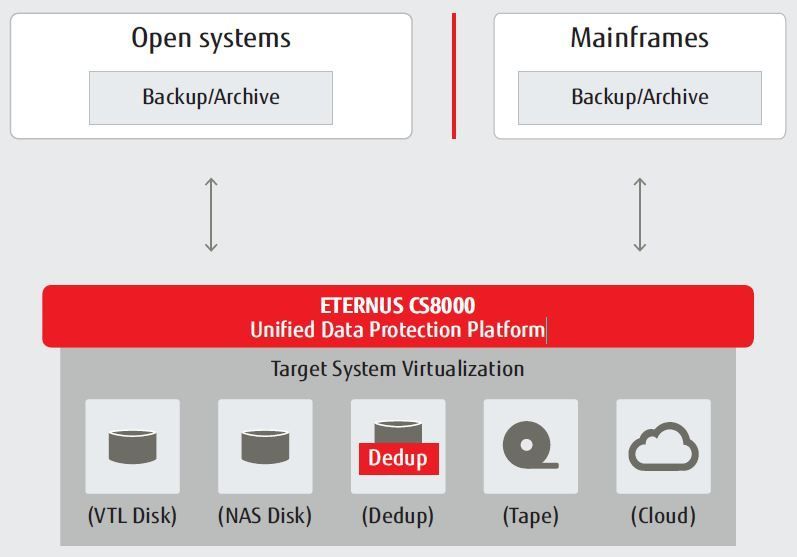

► Einsatz einer Unified-Data-Protection-Plattform, die es ermöglicht, unterschiedliche Technologien zu vereinen und zu managen.

Disk-Backup-Systeme haben die Sicherung deutlich beschleunigt, trotzdem wird immer noch mehr Leistung benötigt. Wie sieht es Ihrer Sicht ein möglichst performanter Backup-Ansatz aus (Stichwort Caching)?

Roth: Die Nutzung von Cache bietet Vorteile sowohl beim Backup als auch beim Restore. Jedoch muss der Cache möglichst flexibel einsetzbar sein, um nicht immer mehr dedizierte Systeme notwendig zu machen. Ein ideales Szenario schließt außerdem eine Unified-Data-Protection-Plattform ein.

Woran erkennen Sie, dass sich in den Unternehmen die Datensicherung in einem Wandel befindet?

Roth: Viele Kunden diskutieren mit uns sowohl neue Konzepte und Möglichkeiten, als auch innovative Infrastrukturen. Außerdem steigen die Anforderungen bei der Archivierung, um die Daten zu klassifizieren und nicht mehr ständig einem Backup unterziehen zu müssen. Die Unified-Data-Protection-Plattform »Fujitsu ETERNUS CS« erfreut sich höchster Beliebtheit, da sie genau diese Probleme löst. Auch ist das Interesse an Object-Storage und unserer hyperskalierbaren »ETERNUS CD10000« sehr groß.

Haben Sie ein besonderes Best-Practice-Beispiel aus dem Backup-Bereich, das Sie beeindruckt hat?

Die »ETERNUS CS8000« als Unified-Data-Protection-Plattform für Backup und Archivierung (Bild: Fujitsu)Roth: Exemplarisch ist ein Projekt, bei dem einer unserer Kunden unsere Unified-Data-Protection-Plattform Eternus CS mit Deduplizierung, Caching, Tape und Backup-to-Disk flexibel und bedarfsgerecht einsetzt. Er archiviert zudem sehr große Datenmengen auf dieser Plattform und nutzt Synergien von Online-Storage und Backup-Infrastruktur, die integriert zusammenarbeiten. Auch Außenstellen sind mittlerweile in diese Lösung eingebunden. Aufgrund dieses ausgefeilten Konzepts profitiert der Kunde von signifikant niedrigeren Kosten, einem geringeren Aufwand in Planung, Integration und Betrieb, und ist bestens gerüstet für ein weiterhin sehr hohes Datenwachstum.

Die »ETERNUS CS8000« als Unified-Data-Protection-Plattform für Backup und Archivierung (Bild: Fujitsu)Roth: Exemplarisch ist ein Projekt, bei dem einer unserer Kunden unsere Unified-Data-Protection-Plattform Eternus CS mit Deduplizierung, Caching, Tape und Backup-to-Disk flexibel und bedarfsgerecht einsetzt. Er archiviert zudem sehr große Datenmengen auf dieser Plattform und nutzt Synergien von Online-Storage und Backup-Infrastruktur, die integriert zusammenarbeiten. Auch Außenstellen sind mittlerweile in diese Lösung eingebunden. Aufgrund dieses ausgefeilten Konzepts profitiert der Kunde von signifikant niedrigeren Kosten, einem geringeren Aufwand in Planung, Integration und Betrieb, und ist bestens gerüstet für ein weiterhin sehr hohes Datenwachstum.

Wie sieht aus Recovery-Aspekten ein möglichst perfekter Mix aus, um größere Datenmengen wieder herzustellen?

Roth: Dabei gilt es mehrere Aspekte zu berücksichtigen:

► Nutzung von Snapshots mit Indizierung (beispielsweise mit »ETERNUS Snapshot Manager«),

► Kombination von Snapshots mit Backup-Software und Infrastruktur,

► Flexible und bedarfsgerechte Nutzung von Caches,

► Ablage der Daten wahlweise auf Enterprise-fähigen Deduplikation-Appliances und/oder auf Tape, gegebenenfalls sogar mehrfach auf Tape und/oder Verweil auf Platten-Caches.

Insgesamt entscheidend ist ein flexibler Einsatz der Ressourcen je nach Bedarf sowie ein Mix aus Technologien (zum Beispiel Deduplizierung und Absicherung zusätzlich auf Tape – aber Transparent für die Applikation), zwischen denen zudem einfach gewechselt werden kann.

Die Cloud wird – vor allem von Cloud-Anbietern – als neue Auslagerungsalternative für Backup-Daten, Archivierung und Replikation propagiert. Wie sehen Sie diesen Ansatz? Ist das die Zukunft? Auch für große Enterprise-Organisationen mit richtig großen Datenbeständen?

Roth: Für bestimmte Archivierungs- oder Absicherungs-Einsatzzwecke von bestimmten Daten ist die Cloud sicherlich ein Mittel, das man in Erwägung ziehen sollte. Für die Sicherung sehr großer Datenmengen oder gar kompletter Backups sind Cloud-Infrastrukturen auf Grund der in WAN-Netzwerken limitierten Transferraten aber nicht die optimale Option. Der Transfer von einem PByte dauert hier nicht etwa Stunden oder Tage, sondern teilweise Wochen. Aus diesen Gründen ziehen Kunden oft Hybrid-Cloud-Architekturen vor. So können sie selbst entscheiden, welche Daten zu welchem Zeitpunkt in die Cloud übertragen werden sollen.

- Storage von Fujitsu

- Fujitsu stattet All-Flash-Array DX200F mit mehr Features aus

- Fujitsu schickt Rechenzentrum in den Stealth-Modus

- Fujitsu schnürt »Eternus DX60 S3« für KMUs zum Einstiegspreis

- Storage-Highlights & Impressionen vom »Fujitsu Forum 2014«

- Mehr über Backup & Recovery im speicherguide.de-Special 01-2015: Einkaufsführer Backup

- Mehr über Backup&Recovery im speicherguide.de-Schwerpunkt