Wenn es heute um Datenspeicherung geht, sind nicht mehr reine Speichersysteme das Thema, vielmehr geht es heute um Verfügbarkeit. Unternehmen benötigen einen sicheren und schnellen Zugriff auf ihre Daten ohne Ausfallzeiten. Die Anforderungen sind deutlich komplexer geworden. Ein Trend, dem sich keiner entziehen kann.

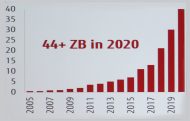

Künstliche Intelligenz und das Internet der Dinge – so abstrakt es heute zum Teil noch klingt – sind dabei treibende Faktoren. Bis 2020 sollen bis zu 50 Milliarden Geräte miteinander vernetzt kommunizieren. »Die Geschwindigkeit mit der die Digitalisierung von Produkten (Smart Products), Geschäftsprozessen, Endgeräten (IoT) oder Produktions- und Logistiksystemen (Industrie 4.0) voranschreitet ist enorm«, sagt Dr. Carlo Velten, CEO bei Crisp Research. »Wir gehen von einem weltweiten jährlichen Datenwachstum von rund 30 bis 40 Prozent und einem Gesamtspeichervolumen von über 50 ZByte im Jahr 2020 aus.« Egal, wie man sich der Thematik nähert, die Datenspeicherung verändert sich drastisch.

Wie sieht moderne Datenspeicherung heute aus?

Storage darf kein Flaschenhals sein

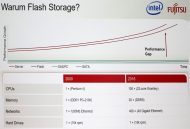

Ein anderer Aspekt, dem der Speicher Rechnung tragen muss: Die Rechenleistung moderner Multikern-Prozessoren hat in den letzten Jahren ungemein zugenommen. »256 Cores und mehr in einer CPU verarbeiten die serverseitigen Processing-Anfragen hunderter virtueller Maschinen parallel«, sagt Thurnhofer. »Vergessen wird dabei aber, dass die Abwicklung speicherseitiger Input/Output-Operationen (I/O) aber seriell erfolgt. Der Speicherdurchsatz wird so zum Flaschenhals für die gesamte Infrastruktur.« Dies führe zu einem Dilemma: Entweder nehme man die Verlangsamung der virtualisierten Applikationen in Kauf, oder muss die Anzahl der Server erhöhen, was den erhofften wirtschaftlichen Nutzen beschneidet.

Disk-Arrays können hier bereits heute nicht mehr mithalten. »Die Festplatte hat sich seit Jahren nicht mehr verändert«, erklärt Stefan Roth, Head of Infrastructure Solutions bei Fujitsu. »Zwar gehen die Kapazitäten nach oben, nicht aber die Performance.«

Stellenwert der HDD im Datacenter

Es ist unbestritten die Festplatte hat Konkurrenz erhalten und ihr Stellenwert sinkt, im Rechenzentrum hat sie aber nach wie vor ihren berichtigten Platz. »Zwar sinken die HDD-Verkäufe nach Stückzahlen, gleichzeitig steigen sie aber hinsichtlich der Kapazität«, argumentiert Datacore-Manager Thurnhofer. »Zudem würde die weltweite Produktionskapazität für SSD derzeit gar nicht ausreichen, um mehr als 20 Prozent des Kapazitätsbedarfs zu decken. So bleibt – vorerst – Disk das günstigere und Flash das schnelle Medium.«

Wie eine kosteneffiziente Datenspeicherung aussieht

Eine moderne Speicherlösung ist auch kein Entweder-oder, sondern basiert auf einer Dateninfrastruktur, die für eine nahtlose Integration und die intelligente Klassifizierung unterschiedlicher Technologien und Systeme sorgt. Die Daten per Auto-Tiering zu klassifizieren ist in den Rechenzentren noch kein Standard, gehört aber sicherlich zu den Funktionen, mit denen sich die IT-Abteilungen beschäftigen. »Bei uns erfolgt die Datenklassifizierung quasi stufenlos auf Block-Level und erfasst hyper-konvergente Systeme, Server-integrierten Flash-Speicher ebenso wie HDD- oder SSD-Subsysteme im SAN«, sagt Thurnhofer. Datacore setzt hier auf seine SDS-Plattformen sowie Parallel-I/O-Technologie. Ein nicht von der Hand zu weisender Unterschied ist dabei: Während Flash einzelne Systeme beschleunigt, kann eine Software-Schicht, die komplette Dateninfrastruktur optimieren.

Möglichst günstig raus aus dem Datensumpf

Zwar steigen die Ansprüche an die Speicherinfrastruktur, gleichzeitig steht Kosten sparen ganz oben auf der To-do-Liste der IT-Abteilungen. Wobei eben die reinen Arrays heute keinen Kostenfaktor mehr darstellen. Firmen können heute Disk-Subsysteme mit redundanten Controller bereits ab rund 5.000 Euro erwerben, selbst von den namhaften Herstellern. Wobei das oft nur die halbe Wahrheit ist. »Wir können nur jedem raten seine eigenen Bedürfnisse genau zu kennen«, sagt N-Tec-Manager Meyerhofer. »Das heißt, welches Maß an I/O-Leistung wird benötigt und sind vermeintlich günstige Systeme auch auf Erweiterbarkeit ausgelegt? Bei Hochverfügbarkeit ist es zudem auch wichtig die gebotenen Service-Level und Ansprechpartner abzuklären.« Im Schadensfall darf es kein Finger-Pointing geben.